基礎統計学の勘どころ #4 回帰分析

前回↓

回帰分析

前置き

例は#3と同じものを用いる。

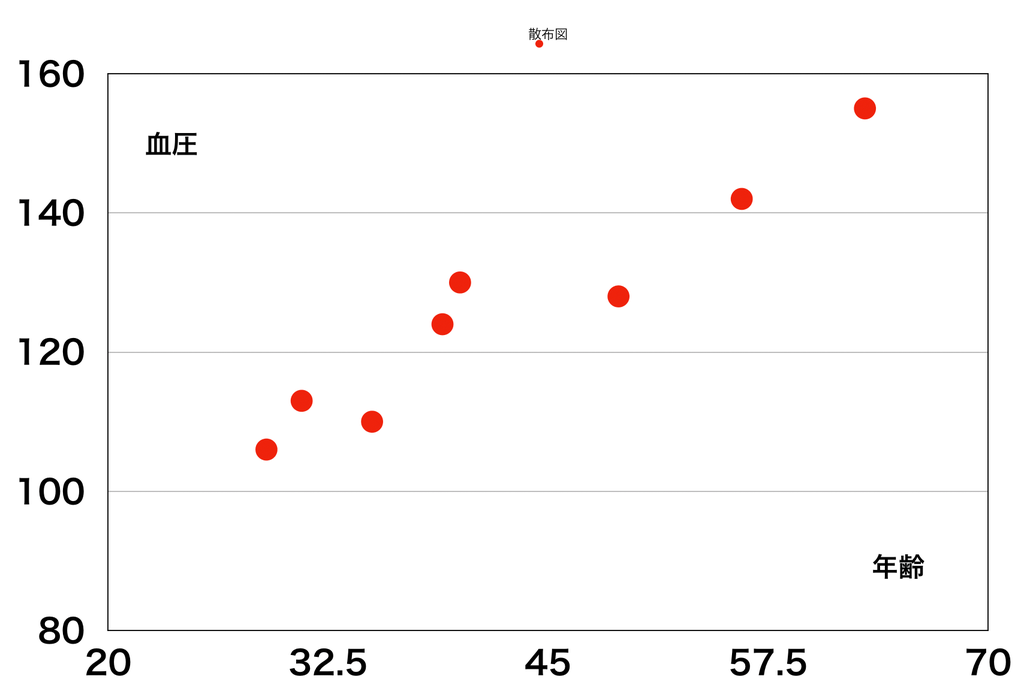

| 年齢 | 29 | 31 | 35 | 39 | 40 | 49 | 56 | 63 |

|---|---|---|---|---|---|---|---|---|

| 血圧 | 106 | 113 | 110 | 124 | 130 | 128 | 142 | 155 |

この散布図をみると,年齢と血圧の関係がで近似できそうである。

こうすれば,今与えられていないデータに関しても年齢から血圧を予測することができるようになる。このように回帰分析とは,得られたデータを関数でモデル化することを目的とする。回帰分析では,おおよそ次のステップをふむ。

- モデルの定義

- 残差の定義

- 残差の最小化

モデルの定義

一般に,真の単回帰直線は

と表される。ここで,は独立変数,

は従属変数,

は誤差である。また

を回帰係数といい,これを推定の対象とする。

誤差については,以下を仮定している。

- 平均は0

- 分散は一定値をとる

- 異なる誤差どうしは互いに無関係

誤差についてはあまり深く考えず,測定誤差のようなものと解しておけばよい(誤差は神のみぞ知る)。

では,与えられたxとyの値から回帰係数を推定して,モデルを推定しよう。推定で得た単回帰直線を

と表すことにする。ここでと

は必ずしも一致するとは限らないことに注意。補足を参照。

残差の定義

さて,以下の直線のうちどれが近似できているものだろうか?

見たところ,左の方が良さそうである。では何が違うのか?

実測値であると推測値である

の差

である残差が違っている。これが小さいほど,よい近似と言えそうである。

ちなみに誤差との違いとして,誤差は測定され得ないが,残差は測定可能であることがあげられる。したがって回帰係数の推定には残差を用いることになる。

残差の最小化

ここで最小二乗法について説明しておく。

ある関数の最小値は,

となるから求められる。

のような多変数関数で最小値を求めるには,偏微分を求めて

となるxとyの値を連立方程式で解く。

偏微分は従属変数が2つ以上ある関数において,1つの従属変数ごとで微分することと思えばよい。を例にイメージしてみよう。

この関数は,いわばお椀みたいな形をとる。ここで,x軸とy軸のそれぞれに沿ってスライスしてみる。

すると,と同じ形となる。これは片方の変数を固定して定数とみなしたときの関数に相当する。これで1つずつ微分を求めていくと

,

より,

のとき,最小値

となる。

では回帰分析に適用してみる。回帰分析では残差の2乗和

を最小にするを求めていく。このために,

を

と

で偏微分して,

,

とすると,式変形により次の正規方程式を得る。

この正規方程式を解くことで,残差の2乗和を最小にすると

が求められる。整理すると,

,

となる。

たとえば年齢と血圧についての単回帰直線は

,

,

,

より

→

と表せる。

最小二乗法の一般的な解法は,たとえば以下に詳しい。

最小二乗法の行列表現(一変数,多変数,多項式) | 高校数学の美しい物語

決定係数

推定された回帰直線がデータとの当てはまりがよいか確認するために,決定係数を求める。そのために,実際のデータと推定された回帰直線から「全変動」「回帰変動」「残差変動」の3つを見ていく。

- 全変動:データ全体のばらつき,

- 回帰変動:回帰直線によるばらつき,

- 残差変動:回帰直線とデータのずれ,

これらを用いて,決定係数 は次のように定義される。

,

要するに決定係数とは,データ全体のばらつきのうち回帰直線によるばらつきがどれだけ影響しているかを示している。つまりが1に近いほど当てはまりがよい。

なお,決定係数は相関係数の2乗と等しい関係にある。

したがって,「相関関係が強い↔︎回帰直線の当てはまりがよい」ということがいえる。

決定係数の導出過程については以下に詳しく書いてある。

http://www.geisya.or.jp/~mwm48961/statistics/coef_det1.htm

補足

単回帰直線に「真の」とか「推測で得た」とあるが,一体何が違うのか?と思われるだろう。これは推測統計学における「母集団」と「標本集団」の違いととらえていただければと思う。今回の例では与えられたデータの特徴をつかむことに重点をおいたが,回帰分析では「与えられたデータから未知のデータを予測する」こともできる。詳しいことについては後日書く予定である。

次回↓