論文Abstract100本ノック#2

前回↓

※変更点

表記:単語→語彙

6 SENet(2017)

原文:

Squeeze-and-excitation networks

Abstract

The central building block of convolutional neural networks (CNNs) is the convolution operator, which enables networks to construct informative features by fusing both spatial and channel-wise information within local receptive fields at each layer.

訳:

畳み込みニューラルネットワーク(CNN)の中心的な構成要素は畳み込み演算子であり,これによりネットワークは各層の局所受容野内で空間情報とチャネルごとの情報の両方を融合することによって有益な機能を構築できる。

A broad range of prior research has investigated the spatial component of this relationship, seeking to strengthen the representational power of a CNN by enhancing the quality of spatial encodings throughout its feature hierarchy.

語彙:

prior research

relationship

spatial

訳:

広範囲の先行研究がこの関係の空間コンポーネントを調査し,その機能階層全体で空間エンコーディングの品質を向上させることによりCNNの表現力を強化しようとしている。

In this work, we focus instead on the channel relationship and propose a novel architectural unit, which we term the “Squeeze-and-Excitation” (SE) block, that adaptively recalibrates channel-wise feature responses by explicitly modelling interdependencies between channels.

語彙:

instead

Squeeze

Excitation

interdependencies

訳:

ここでは代わりにチャネル関係に焦点を当て,チャネル間の相互依存関係を明示的にモデル化することでチャネルごとの機能応答を適応的に再調整する,「Squeeze-and-Excitation」(SE)ブロックと呼ばれる新しいアーキテクチャユニットを提案する。

We show that these blocks can be stacked together to form SENet architectures that generalise extremely effectively across different datasets.

訳:

これらのブロックを積み重ねて異なるデータセットで非常に効果的に一般化するSENetアーキテクチャを形成できることを示す。

We further demonstrate that SE blocks bring significant improvements in performance for existing state-of-the-art CNNs at slight additional computational cost.

語彙:

slight

訳:

さらに,SEブロックがわずかな追加の計算コストで、既存の最先端CNNのパフォーマンスを大幅な向上をもたらすことを示す。

Squeeze-and-Excitation Networks formed the foundation of our ILSVRC 2017 classification submission which won first place and reduced the top-5 error to 2.251%, surpassing the winning entry of 2016 by a relative improvement of ∼25%.

訳:

Squeeze-and-Excitation NetworksはILSVRC 2017分類課題の基礎を形成し1位を獲得し,トップ5エラーを2.251%に減らし,2016年の入賞エントリを~25%の相対的な改善で上回った。

Models and code are available at https://github.com/hujie-frank/SENet.

語彙:

available

訳: モデルとコードはhttps://github.com/hujie-frank/SENetで利用可能である。

7 WideResNet(2016)

原文:

Abstract

Deep residual networks were shown to be able to scale up to thousands of layers and still have improving performance.

訳:

深い残差ネットワークは数千のレイヤーにスケールアップできパフォーマンスが改善されることが示された。

However, each fraction of a percent of improved accuracy costs nearly doubling the number of layers, and so training very deep residual networks has a problem of diminishing feature reuse, which makes these networks very slow to train.

語彙:

percent

diminishing

reuse

訳:

しかし,精度の向上の割合の一部はレイヤー数をほぼ2倍にすることにあり,非常に深い残差ネットワークの学習には機能の再利用が減少するという問題があり,これらのネットワークの学習は非常に遅くなる。

To tackle these problems, in this paper we conduct a detailed experimental study on the architecture of ResNet blocks, based on which we propose a novel architecture where we decrease depth and increase width of residual networks.

語彙:

tackle these problems

conduct

based on

訳:

これらの問題に取り組むために,本論文ではResNetブロックのアーキテクチャに関する詳細な実験的研究を実施し,それに基づいて残差ネットワークの深さを減らし幅を広げる新しいアーキテクチャを提案する。

We call the resulting network structures wide residual networks (WRNs) and show that these are far superior over their commonly used thin and very deep counterparts.

語彙:

thin

counterparts

訳:

結果のネットワーク構造をwide residual networks(WRN)と呼び,これらが一般的に使用される薄く非常に深い対照のものよりもはるかに優れていることを示す。

For example, we demonstrate that even a simple 16-layer-deep wide residual network outperforms in accuracy and efficiency all previous deep residual networks, including thousand-layerdeep networks, achieving new state-of-the-art results on CIFAR, SVHN, COCO, and significant improvements on ImageNet.

訳:

たとえば,単純な16層の深さのWRNでも1000層の深さのネットワークを含む以前のすべての深層残差ネットワークの精度と効率が優れていることを実証しており,CIFAR,SVHN,COCOの最新の結果を達成しImageNetの大幅な更新を示している。

Our code and models are available at https://github.com/szagoruyko/wide-residual-networks.

語彙:

訳:コードとモデルは,https://github.com/szagoruyko/wide-residual-networksで入手できる。

8 PyramidNet(2016)

原文:

Deep pyramidal residual networks

Abstract

Deep convolutional neural networks (DCNNs) have shown remarkable performance in image classification tasks in recent years.

語彙:

remarkable

訳:

DCNNは近年の画像分類タスクで顕著なパフォーマンスを示している。

Generally, deep neural network architectures are stacks consisting of a large number of convolutional layers, and they perform downsampling along the spatial dimension via pooling to reduce memory usage.

単語:

downsampling

訳:

一般に,DNNアーキテクチャは多数の畳み込み層で構成されるスタックであり,メモリ使用量を削減するためにプーリングを介して空間次元に沿ってダウンサンプリングを実行する。

Concurrently, the feature map dimension (i.e., the number of channels) is sharply increased at downsampling locations, which is essential to ensure effective performance because it increases the diversity of high-level attributes.

語彙:

Concurrently

i.e.

essential

diversity

訳:

同時に,機能マップの次元(つまりチャネル数)はダウンサンプリング位置で急激に増加する,これは高レベルの属性の多様性を高めるため効果的なパフォーマンスを確保するために不可欠です。

This also applies to residual networks and is very closely related to their performance.

訳:

これは残差ネットワークにも適用され,それらのパフォーマンスに非常に密接に関連している。

In this research, instead of sharply increasing the feature map dimension at units that perform downsampling, we gradually increase the feature map dimension at all units to involve as many locations as possible.

語彙:

feature map

gradually

訳:

この研究では,ダウンサンプリングを実行するユニットで特徴マップの次元を大幅に増やす代わりに,できるだけ多くの場所を含むようにすべてのユニットで特徴マップの次元を徐々に増やす。

This design, which is discussed in depth together with our new insights, has proven to be an effective means of improving generalization ability.

語彙:

insights

訳:

この設計は,新しい洞察とともに詳細に説明されており,一般化能力を向上させる効果的な手段であることが証明されている。

Furthermore, we propose a novel residual unit capable of further improving the classification accuracy with our new network architecture.

訳:

さらに,新しいネットワークアーキテクチャで分類精度をさらに向上させることができる新しい残差ユニットを提案する。

Experiments on benchmark CIFAR-10, CIFAR-100, and ImageNet datasets have shown that our network architecture has superior generalization ability compared to the original residual networks.

語彙:

Experiments

訳:

ベンチマークCIFAR-10、CIFAR-100、およびImageNetデータセットの実験にて,ネットワークアーキテクチャが元の残差ネットワークと比較して優れた一般化能力を持っていることが示された。

Code is available at https://github.com/jhkim89/PyramidNet.

訳: コードはhttps://github.com/jhkim89/PyramidNetで入手できる。

9 ResNeXt(2016)

原文:

Aggregated residual transformations for deep neural networks

Abstract

We present a simple, highly modularized network architecture for image classification.

訳:

画像分類のためのシンプルで高度にモジュール化されたネットワークアーキテクチャを紹介する。

Our network is constructed by repeating a building block that aggregates a set of transformations with the same topology.

語彙:

aggregates

訳:

ネットワークは同じトポロジーで一連の変換を集約するビルディングブロックを繰り返すことで構築される。

Our simple design results in a homogeneous, multi-branch architecture that has only a few hyper-parameters to set.

語彙:

homogeneous

multi-branch

訳:

シンプルな設計によって,設定するハイパーパラメーターがわずかな均質な分岐アーキテクチャが実現する。

This strategy exposes a new dimension, which we call "cardinality" (the size of the set of transformations), as an essential factor in addition to the dimensions of depth and width.

語彙:

exposes

cardinality

訳:

この戦略は深さと幅の次元に加えて,重要な要素として「cardinality」(変換セットのサイズ)と呼ばれる新しい次元を導入する。

On the ImageNet-1K dataset, we empirically show that even under the restricted condition of maintaining complexity, increasing cardinality is able to improve classification accuracy.

語彙:

empirically

even under

訳:

ImageNet-1Kデータセットで,複雑さを維持するという制限された条件下でも,cardinalityを増加させると分類精度が向上することが経験的に示されている。

Moreover, increasing cardinality is more effective than going deeper or wider when we increase the capacity.

訳:

さらに,容量を増やすときにcardinalityを増やすことは深くまたは広くするよりも効果的である。

Our models, named ResNeXt, are the foundations of our entry to the ILSVRC 2016 classification task in which we secured 2nd place.

訳:

ResNeXtと名付けられたこのモデルは,2位を獲得したILSVRC 2016分類タスクへのエントリーの基盤である。

We further investigate ResNeXt on an ImageNet-5K set and the COCO detection set, also showing better results than its ResNet counterpart.

語彙:

investigate

訳:

ImageNet-5KセットおよびCOCO検出セットでResNeXtをさらに調査し、ResNetよりも良い結果を示している。

The code and models are publicly available online.

訳:

コードとモデルはオンラインで公開されている。

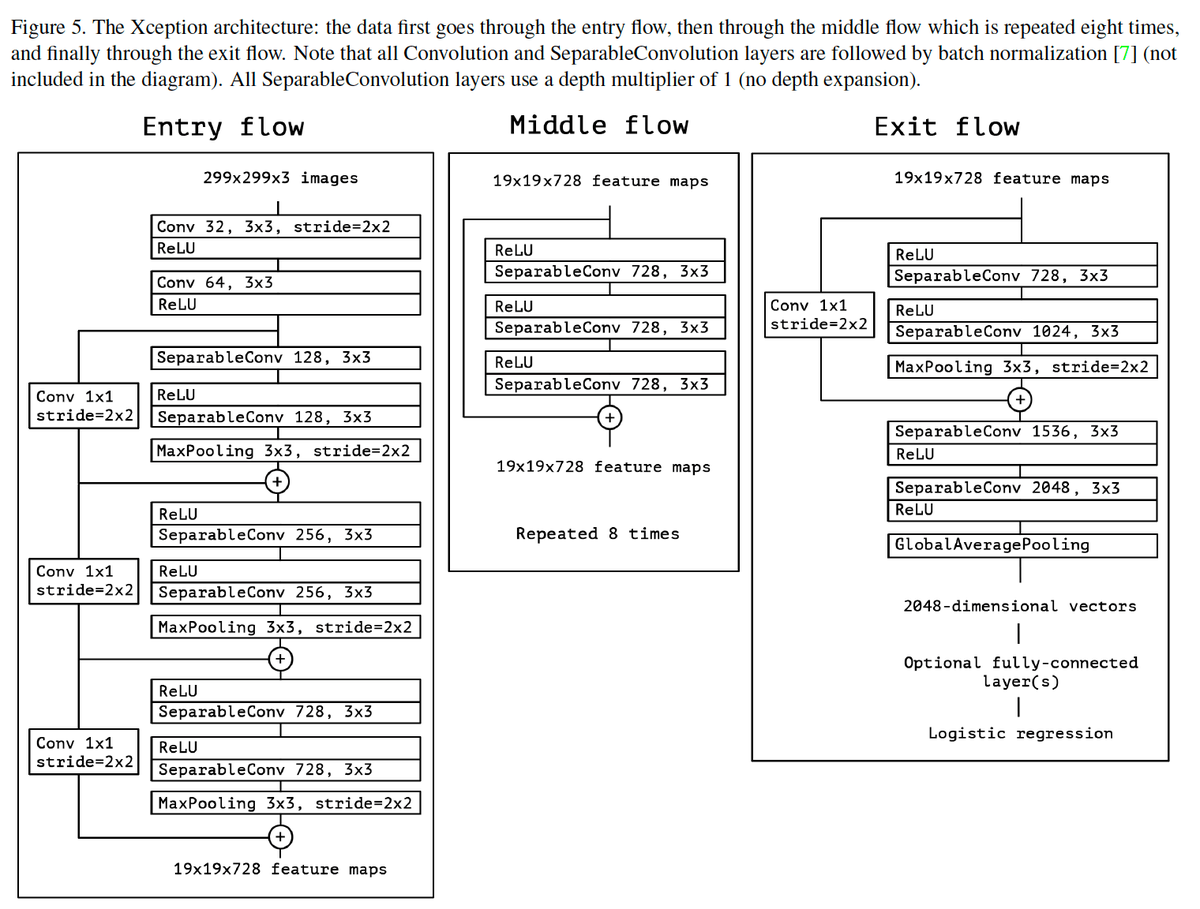

10 Xception(2016)

原文:

Xception: Deep learning with depthwise separable convolutions

Abstract

We present an interpretation of Inception modules in convolutional neural networks as being an intermediate step in-between regular convolution and the depthwise separable convolution operation (a depthwise convolution followed by a pointwise convolution).

語彙:

interpretation

intermediate

訳:

CNNのInceptionモジュールの解釈について,通常の畳み込みと深さ方向に分離可能な畳み込み操作(深さ方向の畳み込みに続いて点ごとの畳み込み)の中間ステップとして提示する。

In this light, a depthwise separable convolution can be understood as an Inception module with a maximally large number of towers.

語彙:

In this light

訳:

この観点から,深さ方向に分離可能な畳み込みは最大数の段を持つInceptionモジュールとして理解できる。

This observation leads us to propose a novel deep convolutional neural network architecture inspired by Inception, where Inception modules have been replaced with depthwise separable convolutions.

語彙:

leads us to

inspired

訳:

この観察に基づいて,Inceptionにインスパイアされた新しいDCNNアーキテクチャを提案する,ここでInceptionモジュールは深さ方向に分離可能な畳み込みに置き換えられている。

We show that this architecture, dubbed Xception, slightly outperforms Inception V3 on the ImageNet dataset (which Inception V3 was designed for), and significantly outperforms Inception V3 on a larger image classification dataset comprising 350 million images and 17,000 classes.

語彙:

dubbed

slightly

outperforms

significantly

訳:

Xceptionと呼ばれるこのアーキテクチャは,ImageNetデータセット(Inception V3の設計対象)でInception V3をわずかに上回り,3億5千万の画像と17,000のクラスで構成される大きな画像分類データセットでInception V3を大幅に上回ることを示す。

Since the Xception architecture has the same number of parameters as Inception V3, the performance gains are not due to increased capacity but rather to a more efficient use of model parameters.

語彙:

not ~ but rather to -

訳:

XceptionアーキテクチャにはInception V3と同じ数のパラメーターがあるため,パフォーマンスの向上は容量の増加によるものではなくモデルパラメーターのより効率的な使用によるものである。

次回↓