論文Abstract100本ノック#4

前回↓

今回から画像生成問題で頻用されるGANを扱っていく。

参考記事:

16 GAN(2014)

原文:

Generative Adversarial Networks

Abstract

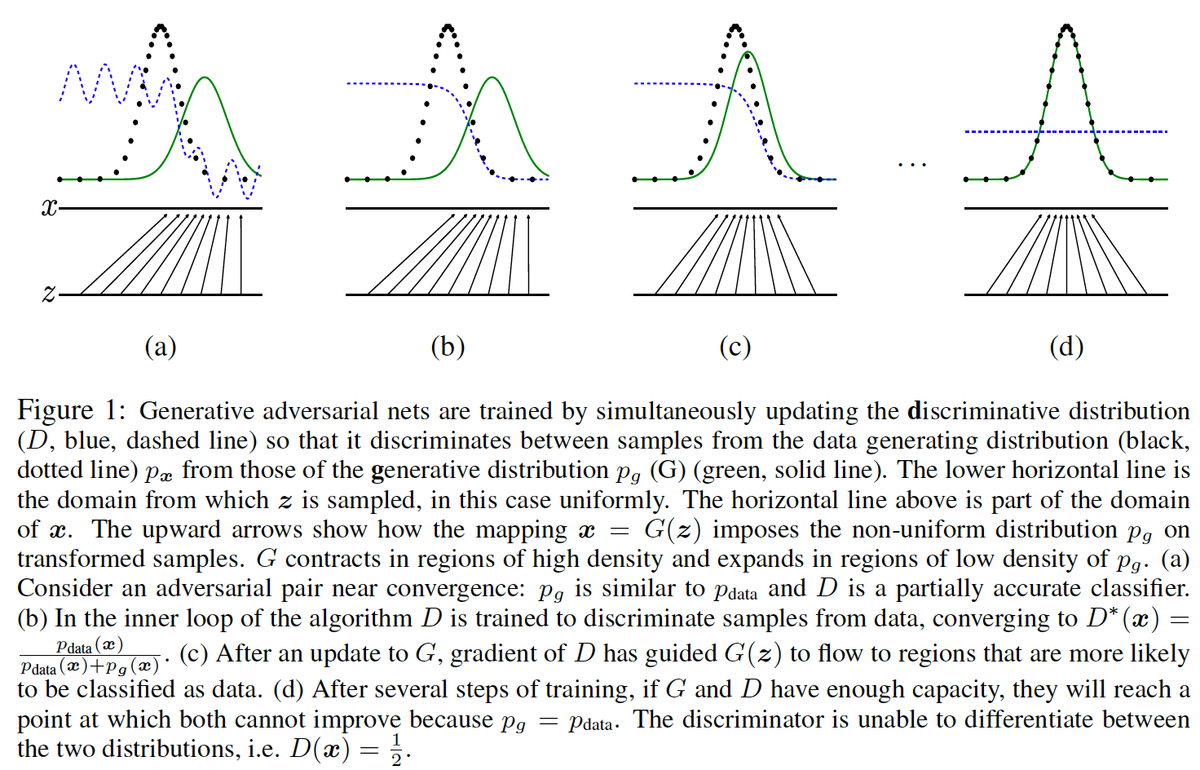

We propose a new framework for estimating generative models via an adversarial process, in which we simultaneously train two models:

a generative model G that captures the data distribution, and a discriminative model D that estimates the probability that a sample came from the training data rather than G.

語彙:

generative

via

adversarial

distribution

discriminative

訳:

敵対的プロセスを介して生成モデルを推定するための新しいフレームワークを提案する,このプロセスでは2つのモデルを同時に学習する:

データ分布をキャプチャする生成モデルGと,Gではなく学習データからサンプルが取得された確率を推定する判別モデルD。

The training procedure for G is to maximize the probability of D making a mistake.

語彙:

procedure

訳:

Gの学習手続きはDがミスをする確率を最大化することである。

This framework corresponds to a minimax two-player game.

語彙:

corresponds

minimax

訳:

このフレームワークはミニマックスの2人用ゲームに対応している。

In the space of arbitrary functions G and D, a unique solution exists, with G recovering the training data distribution and D equal to 1/2 everywhere.

語彙:

arbitrary

unique solution

訳:

任意の関数GとDの空間には,Gが学習データの分布をリカバリーし,Dがどこでも1/2に等しいという一意解が存在する。

In the case where G and D are defined by multilayer perceptrons, the entire system can be trained with backpropagation.

語彙:

entire

backpropagation

訳:

GとDが多層パーセプトロンで定義されている場合,システム全体を逆伝播で学習できる。

There is no need for any Markov chains or unrolled approximate inference networks during either training or generation of samples.

語彙:

approximate inference

訳:

サンプルの学習または生成中にマルコフ連鎖または展開された近似推論ネットワークは必要ない。

Experiments demonstrate the potential of the framework through qualitative and quantitative evaluation of the generated samples.

語彙:

qualitative

quantitative

訳:

実験によって生成されたサンプルの定性的および定量的評価を通じてフレームワークの可能性を示される。

17 DCGAN(2015)

原文:

Unsupervised Representation Learning with Deep Convolutional Generative Adversarial Networks

Abstract

In recent years, supervised learning with convolutional networks (CNNs) has seen huge adoption in computer vision applications.

語彙:

huge

訳:

近年,畳み込みネットワーク(CNN)による教師あり学習はコンピュータービジョンアプリケーションで大規模に採用されている。

Comparatively, unsupervised learning with CNNs has received less attention.

訳:

それに比べて,CNNによる教師なし学習はあまり注目されていない。

In this work we hope to help bridge the gap between the success of CNNs for supervised learning and unsupervised learning.

訳:

ここで,教師あり学習と教師なし学習のCNNの成功の間のギャップを埋めることを支援したいと考えている。

We introduce a class of CNNs called deep convolutional generative adversarial networks (DCGANs), that have certain architectural constraints, and demonstrate that they are a strong candidate for unsupervised learning.

語彙:

constraints

candidate

訳:

特定のアーキテクチャ上の制約があるdeep convolutional generative adversarial networks(DCGAN)と呼ばれるCNNのクラスを紹介し,教師なし学習の強力な候補であることを示す。

Training on various image datasets, we show convincing evidence that our deep convolutional adversarial pair learns a hierarchy of representations from object parts to scenes in both the generator and discriminator.

語彙:

scenes

訳:

さまざまな画像データセットの学習で,deep convolutional adversarial pairがオブジェクトパーツからgeneratorとdiscriminatorの両方のシーンまでの表現の階層を学習するという説得力のある証拠を示している。

Additionally, we use the learned features for novel tasks - demonstrating their applicability as general image representations.

訳:

さらに,学習した機能を新しいタスクに使用し,一般的な画像表現としての適用性を示す。

18 PCGAN(2017)

原文:

Progressive Growing of GANs for Improved Quality, Stability, and Variation

Abstract

We describe a new training methodology for generative adversarial networks.

語彙:

methodology

訳:

GANの新しい学習方法を説明する。

The key idea is to grow both the generator and discriminator progressively:

starting from a low resolution, we add new layers that model increasingly fine details as training progresses.

語彙:

progressively

resolution

訳:

重要なアイデアはgeneratorとdiscriminatorの両方を段階的に成長させることである:

低解像度から始めて,学習が進むにつれてますます細かいディテールをモデル化する新しいレイヤーを追加する。

This both speeds the training up and greatly stabilizes it, allowing us to produce images of unprecedented quality, e.g., CelebA images at 1024^2.

語彙:

stabilizes

unprecedented

訳:

これにより学習速度が向上し学習が大幅に安定します,これにより前例のない品質の画像(1024^2のCelebA画像など)を作成できる。

We also propose a simple way to increase the variation in generated images, and achieve a record inception score of 8.80 in unsupervised CIFAR10.

訳:

また,生成された画像のバリエーションを増やす簡単な方法を提案し,教師なしCIFAR10で記録開始スコア8.80を達成する。

Additionally, we describe several implementation details that are important for discouraging unhealthy competition between the generator and discriminator.

語彙:

implementation

unhealthy

訳:

さらに,generatorとdiscriminator間の不要な競争を阻止するために重要ないくつかの実装の詳細について説明する。

Finally, we suggest a new metric for evaluating GAN results, both in terms of image quality and variation.

語彙:

metric

訳:

最後に,画像の質とバリデーションとの両方の観点から,GANの結果を評価するための新しい指標を提案する。

As an additional contribution, we construct a higher-quality version of the CelebA dataset.

訳:

加えて,CelebAデータセットの高品質バージョンを構築する。

19 ACGAN(2016)

原文:

Conditional Image Synthesis With Auxiliary Classifier GANs

Abstract

Synthesizing high resolution photorealistic images has been a long-standing challenge in machine learning.

語彙:

Synthesizing

long-standing

訳:

高解像度の写真のようにリアルな画像を合成することは機械学習において長年の課題であった。

In this paper we introduce new methods for the improved training of generative adversarial networks (GANs) for image synthesis.

訳:

この論文では画像合成のための生成的敵対ネットワーク(GAN)の改善されたトレーニングのための新しい方法を紹介する。

We construct a variant of GANs employing label conditioning that results in 128x128 resolution image samples exhibiting global coherence.

語彙:

employing

訳:

ラベル調整を採用したGANのバリアントを構築し,結果として128x128の解像度の画像サンプルがグローバルな一貫性を示す。

We expand on previous work for image quality assessment to provide two new analyses for assessing the discriminability and diversity of samples from class-conditional image synthesis models.

語彙:

discriminability

訳:

画質評価の以前の作業を拡張してクラス条件付き画像合成モデルからのサンプルの識別可能性と多様性を評価するための2つの新しい分析を提供する。

These analyses demonstrate that high resolution samples provide class information not present in low resolution samples.

訳:

これらの分析は高解像度サンプルが低解像度サンプルには存在しないクラス情報を提供することを示す。

Across 1000 ImageNet classes, 128x128 samples are more than twice as discriminable as artificially resized 32x32 samples.

語彙:

artificially

訳:

1000個のImageNetクラスにわたって,128x128サンプルは人為的にサイズ変更された32x32サンプルの2倍以上の識別が可能です。

In addition, 84.7% of the classes have samples exhibiting diversity comparable to real ImageNet data.

単語:

訳:

さらに,クラスの84.7%には実際のImageNetデータに匹敵する多様性を示すサンプルがある。

20 SAGAN(2018)

原文:

Self-Attention Generative Adversarial Networks

Abstract

In this paper, we propose the Self-Attention Generative Adversarial Network (SAGAN) which allows attention-driven, long-range dependency modeling for image generation tasks.

訳:

この論文では,画像生成タスクのための注意駆動型の長距離依存性モデリングを可能にするSelf-Attention Generative Adversarial Network(SAGAN)を提案します。

Traditional convolutional GANs generate high-resolution details as a function of only spatially local points in lower-resolution feature maps.

訳:

従来のcGANは低解像度の特徴マップの空間的に局所的な点のみの関数として高解像度の詳細を生成する。

In SAGAN, details can be generated using cues from all feature locations.

語彙:

cues

訳:

SAGANでは,すべての特徴点からのキューを使用して詳細を生成できる。

Moreover, the discriminator can check that highly detailed features in distant portions of the image are consistent with each other.

語彙:

consistent

訳:

さらに,discriminatorは画像の離れた部分の非常に詳細な特徴が互いに整合していることを確認できる。

Furthermore, recent work has shown that generator conditioning affects GAN performance.

訳:

さらに,最近の研究ではgeneratorの調整がGANのパフォーマンスに影響することが示されている。

Leveraging this insight, we apply spectral normalization to the GAN generator and find that this improves training dynamics.

語彙:

Leveraging

dynamics

訳:

この洞察を活用して,GANのgeneratorにスペクトル正規化を適用し,これにより学習ダイナミクスが改善されることがわかる。

The proposed SAGAN achieves the state-of-the-art results, boosting the best published Inception score from 36.8 to 52.52 and reducing Frechet Inception distance from 27.62 to 18.65 on the challenging ImageNet dataset.

訳:

提案されたSAGANは最先端の結果を達成し,公開されているInception scoreの最高値を36.8から52.52に引き上げ,ImageNetデータセットのFrechet Inception distanceを27.62から18.65に減少させる。

Visualization of the attention layers shows that the generator leverages neighborhoods that correspond to object shapes rather than local regions of fixed shape.

語彙:

neighborhoods

rather than

訳:

attentionレイヤーを視覚化すると,generatorは固定形状のローカル領域ではなくオブジェクトの形状に対応する近傍を活用することがわかる。

次回↓

金匱要略と現代漢方との比較 #9 第20章 婦人妊娠病脈證并治,第21章 婦人產後病脈證治,第22章 婦人雜病脈證并治

第20章 婦人妊娠病脈證并治

薬方

桂枝茯苓丸

婦人宿有癥病,經斷未及三月,而得漏下不止。胎動在臍上者,為癥痼害。妊娠六月動者,前三月經水利時胎。下血者,後斷三月衃也。所以血不止者,其癥不去故也,當下其癥,桂枝茯苓丸主之。

桂枝茯苓丸方:桂枝;茯苓;牡丹去心;桃仁去皮、尖,熬;芍藥各等分。

右五味,末之,煉蜜和丸如兔屎大,每日食前服一丸,不知,加至三丸。

成分・分量

- 桂皮 3-4

- 茯苓 4

- 牡丹皮 3-4

- 桃仁 4

- 芍薬 4

用法・用量

(1)散:1 回 2-3g 1 日 3 回

(2)湯

効能・効果

比較的体力があり、ときに下腹部痛、肩こり、頭重、めまい、のぼせて足冷えなどを訴えるものの次の諸症: 月経不順、月経異常、月経痛、更年期障害、血の道症注)、肩こ り、めまい、頭重、打ち身(打撲症)、しもやけ、しみ、湿疹・ 皮膚炎、にきび

《備考》 注)血の道症とは、月経、妊娠、出産、産後、更年期など女性 のホルモンの変動に伴って現れる精神不安やいらだちなどの精神神経症状および身体症状のことである。

解説

癥病は瘀血による子宮内の塊(今でいう子宮筋腫)を指す。牡丹皮・桃仁を中心に駆瘀血作用を示し,桂枝は気,茯苓は水の流れを改善する。

芎帰膠艾湯

師曰:婦人有漏下者,有半產後因續下血都不絕者,有妊娠下血者。假令妊娠腹中痛,為胞阻,膠艾湯主之。

芎歸膠艾湯方:芎窮、阿膠、甘草各二兩,艾葉、當歸各三兩,芍藥四兩,乾地黃。

右七味,以水五升,清酒五升,合煮取三升,去滓,內膠令消盡,溫服一升,日三服,不差更作。

成分・分量

- 川芎 3

- 甘草 3

- 艾葉 3

- 当帰 4-4.5

- 芍薬 4-4.5

- 地黄 5-6

- 阿膠3

効能・効果

体力中等度以下で、冷え症で、出血傾向があり胃腸障害のない ものの次の諸症:痔出血、貧血、月経異常・月経過多・不正出血、皮下出血

解説

気血虚による継続的な出血症状に適応する。それぞれの生薬が補血,活血にはたらく。

当帰芍薬散

婦人懷娠,腹中㽲痛,當歸芍藥散主之。

當歸芍藥散方:當歸三兩,芍藥一斤,茯苓四兩,白朮四兩,澤瀉半斤,芎藭半斤。

右六味,杵為散,取方寸匕,酒和,日三服。

成分・分量

- 当帰 3-3.9

- 川芎 3

- 芍薬 4-16

- 茯苓 4-5

- 白朮 4-5(蒼朮も可)

- 沢瀉 4-12

用法・用量

(1)散:1 回 1-2g 1 日 3 回

(2)湯

効能・効果

体力虚弱で、冷え症で貧血の傾向があり疲労しやすく、ときに下腹部痛、頭重、めまい、肩こり、耳鳴り、動悸などを訴える ものの次の諸症: 月経不順、月経異常、月経痛、更年期障害、産前産後あるいは 流産による障害(貧血、疲労倦怠、めまい、むくみ)、めまい・ 立ちくらみ、頭重、肩こり、腰痛、足腰の冷え症、しもやけ、 むくみ、しみ、耳鳴り

解説

虚証で特に妊娠中の腹部の張りや痛みに適応する。当帰・川芎の補血作用,茯苓・沢瀉・白朮の利水作用により諸症状を改善する。

乾姜人参半夏丸

妊娠嘔吐不止,乾姜人參半夏丸主之。

乾姜人參半夏丸方:乾姜、人參各一兩,半夏二兩。

右三味,末之,以生姜汁糊為丸如梧子大,飲服十丸,日三服。

成分・分量

- 乾姜 3

- 人参 3

- 半夏 6

用法・用量

(1)散:1 回 1.5-5g 1 日 3 回

(2)湯:上記量を 1 日量とする。

効能・効果

体力中等度以下で、はきけ・嘔吐が続きみぞおちのつかえを感じるものの次の諸症:つわり、胃炎、胃腸虚弱

解説

脾胃虚が原因の悪阻を改善する処方で,乾姜は脾胃を温めて,人参は脾胃の気を補い,半夏・生姜は吐き気を止める構成である。

当帰散

婦人妊娠,宜常服當歸散主之。

當歸散方:當歸、黃芩、芍藥、芎藭各一兩,白朮半斤。

右五味,杵為散,酒飲服方寸匕,日再服。妊娠常服即易產,胎無苦疾,產後百病悉主之。

成分・分量

- 当帰 2-3

- 芍薬 2-3

- 川芎 2-3

- 黄芩 2-3

- 白朮 1-1.5(蒼朮も可)

用法・用量

(1)散:1 回 1-2g 1 日 3 回

(2)湯

効能・効果

体力中等度以下のものの次の諸症:産前産後の障害(貧血、疲労倦怠、めまい、むくみ)

解説

妊婦の万能薬として記述されている。実際には気血虚で寒熱虚実が錯雑した状態に適応する。

第21章 婦人產後病脈證治

産後病

状態

問曰:新產婦人有三病,一者病痓,二者病鬱冒,三者大便難,何謂也?師曰:新產血虛,多汗出,喜中風,故令病痓;亡血復汗,寒多故令鬱冒;亡津液,胃燥,故大便難。

産後の病として3つあげられている。原因は気血や陰の虚である。

- 痙:痙攣,四肢のひきつり

- 鬱冒:精神減退

- 大便難:便秘

薬方

小柴胡湯(第17章解説済み)

產婦鬱冒,其脈微弱,不能食,大便反堅,但頭汗出。所以然者,血虛而厥,厥而必冒,冒家欲解,必大汗出。以血虛下厥,孤陽上出,故頭汗出。所以產婦喜汗出者,亡陰血虛,陽氣獨盛,故當汗出,陰陽乃復。大便堅,嘔不能食,小柴胡湯主之。

大承気湯(第2章解説済み)

病解能食,七八日更發熱者,此為胃實,大承氣湯主之。 產後七八日,無太陽證,少腹堅痛,此惡露不盡,大便,煩躁發熱,切脈微實,再倍發熱,日晡時煩躁者,不食,食則讝語,至夜即愈,宜大承氣湯主之。熱在裏,結在膀胱也。

桂枝湯(第17章解説済み)

產後風,續之數十日不解,頭微痛,惡寒,時時有熱,心下悶,乾嘔汗出。雖又,陽旦證續在耳,可與陽旦湯。(即桂枝湯方,見下利中)

小柴胡湯(第17章解説済み)

三物黄芩湯

《千金》三物黃芩湯:治婦人在草蓐,自發露得風,四肢苦煩熱,頭痛者,與小柴胡湯。頭不痛但煩者,此湯主之。

黃芩一兩,苦參二兩,乾地黃四兩。

右三味,以水八升,煮取二升,溫服一升,多吐下虫。

成分・分量

- 黄芩 1.5-3

- 苦参 3

- 地黄 6

効能・効果

体力中等度又はやや虚弱で、手足のほてりがあるものの次の諸症: 湿疹・皮膚炎、手足のあれ(手足の湿疹・皮膚炎)、不眠

解説

産後,気血が虚したときに風湿邪が侵入することで状態に適応する。特に清熱,燥湿作用が強い構成である。

当帰建中湯

《千金》內補當歸建中湯:治婦人產後虛羸不足,腹中刺痛不止,吸吸少氣,或苦少腹中急,摩痛引腰皆,不能食飲。產後一月,日得服四五劑為善。令人強壯宜。

當歸四兩,桂枝三兩,芍藥六兩,生姜三兩,甘草二兩,大棗十二枚。

右六味,以水一斗,煮取三升,分溫三服,一日令盡。若大虛,加飴糖六兩,湯成內之於火上煖,令飴消,若去血過多,崩內衄不止,加地黃六兩、阿膠二兩,合八味,湯成內阿膠。若無當歸,以芎藭代之;若無生姜,以乾姜代之。

成分・分量

- 当帰 4

- 桂皮 3-4

- 生姜 1-1.5(ヒネショウガを使用する場合 4)

- 大棗 3-4

- 芍薬 5-7.5

- 甘草 2-2.5

- 膠飴 20(膠飴はなくても可)

効能・効果

体力虚弱で、疲労しやすく血色のすぐれないものの次の諸症: 月経痛、月経困難症、月経不順、腹痛、下腹部痛、腰痛、痔、脱肛の痛み、病後・術後の体力低下

解説

産後,気血の虚によりひきつるような痛みや食欲不振に陥った状態に適応する。小建中湯に当帰を加えた構成である。

第22章 婦人雜病脈證并治

薬方

小柴胡湯(第17章解説済み)

婦人中風七八日,續來寒熱,發作有時,經水適斷,此為熱入血室。其血必結,故使如瘧狀,發作有時,小柴胡湯主之。

半夏厚朴湯

婦人咽中如有炙臠,半夏厚朴湯主之。

半夏厚朴湯方:半夏,厚朴三兩,茯苓四兩,生姜五兩,乾蘇葉二兩。

右五味,以水七升,煮取四升,分溫四服,日三夜一服。

成分・分量

- 半夏 6-8

- 茯苓 5

- 厚朴 3

- 蘇葉 2-3

- 生姜 1-2(ヒネショウガを使用する場合 2-4)

効能・効果

体力中等度をめやすとして、気分がふさいで、咽喉・食道部に 異物感があり、ときに動悸、めまい、嘔気などを伴う次の諸症: 不安神経症、神経性胃炎、つわり、せき、しわがれ声、のどの つかえ感

解説

炙臠とは炙った肉が喉にへばりつく様を示しており,咽喉・食道部の異物感に相当する。これは肝の気鬱に起因しており,半夏・厚朴を中心に気を巡らせる。

甘麦大棗湯

婦人藏躁,喜悲傷欲哭,象如神靈所作,數欠伸,甘麥大棗湯主之。

甘草小麥大棗湯方:甘草二兩,小麥一升,大棗十枚。

右三味,以水六升,煮取三升,溫分三服,亦補脾氣。

成分・分量

- 甘草 3-5

- 大棗 2.5-6

- 小麦 14-20

効能・効果

体力中等度以下で、神経が過敏で、驚きやすく、ときにあくびが出るものの次の諸症:不眠症、小児の夜泣き、ひきつけ

解説

例えば月経前症候群におけるイライラ感や突発的な怒りを鎮める。

小青竜湯(第12章解説済み)

婦人吐涎沫,醫反下之,心下即痞,當先治其吐涎沫,小青龍湯主之。涎沫止,乃治痞,瀉心湯主之。

温経湯

問曰:婦人年五十所,病下利數十日不止,暮即發熱,少腹裏急,腹滿,手掌煩熱,唇口乾燥,何也?師曰:此病屬帶下,何以故?曾經半產,瘀血在少腹不去。何以知之?其證唇口乾燥,故知之,當以溫經湯主之。

溫經湯方:吳茱萸三兩;當歸、芎藭、芍藥各二兩;人參;桂枝;阿膠;牡丹皮,;生姜;甘草各二兩;半夏半升;麥門冬一升,去心。

右十二味,以水一斗,煮取三升,分溫三服。亦主婦人少腹寒,久不受胎,兼取崩中去血,或月水來過多,及至期不來。

成分・分量

効能・効果

体力中等度以下で、手足がほてり、唇がかわくものの次の諸症: 月経不順、月経困難、こしけ(おりもの)、更年期障害、不眠、 神経症、湿疹・皮膚炎、足腰の冷え、しもやけ、手あれ(手の 湿疹・皮膚炎)

解説

更年期に伴うほてりや腹満など,広範囲の婦人病に適応する。

当帰芍薬散(第20章解説済み)

婦人腹中諸疾痛,當歸芍藥散主之。

小建中湯(第6章解説済み)

婦人腹中痛,小建中湯主之。

八味地黄丸(第5章解説済み)

問曰:婦人病,飲食如故,煩熱不得臥,而反倚息者,何也?師曰:此名轉胞,不得溺也。以胞絲了戾,故致此病。但利小便則愈,宜腎氣丸主之。

腎氣丸方:乾地黃八兩;署蕷四兩;山茱萸四兩;澤瀉;茯苓三兩;牡丹皮三兩;桂枝;附子,炮,各一兩。

右八味,末之,煉蜜和丸梧子大,酒下十五丸,加至二十五丸,日再服。

(終)

論文Abstract100本ノック#3

前回↓

11 RoR(2016)

原文:

Residual networks of residual networks: Multilevel residual networks

Abstract

A residual-networks family with hundreds or even thousands of layers dominates major image recognition tasks, but building a network by simply stacking residual blocks inevitably limits its optimization ability.

語彙:

dominates

inevitably

訳:

数百または数千のレイヤーを持つ残差ネットワークファミリーは主要な画像認識タスクの中心的存在であるが、残差ブロックを単純に積み重ねてネットワークを構築するとその最適化能力が必然的に制限される。

This paper proposes a novel residual-network architecture, Residual networks of Residual networks (RoR), to dig the optimization ability of residual networks.

語彙:

dig

訳:

この論文は残差ネットワークの最適化能力を発掘するために,新しい残差ネットワークアーキテクチャであるResidual networks of Residual networks(RoR)を提案する。

RoR substitutes optimizing residual mapping of residual mapping for optimizing original residual mapping.

語彙:

substitutes

訳:

RoRは元の残差マッピングを最適化するための残差マッピングの残差マッピングを最適化する代用品である。

In particular, RoR adds level-wise shortcut connections upon original residual networks to promote the learning capability of residual networks.

語彙:

level-wise

訳:

特に,RoRは元の残差ネットワークにレベルごとのショートカット接続を追加して残差ネットワークの学習機能を促進する。

More importantly, RoR can be applied to various kinds of residual networks (ResNets, Pre-ResNets and WRN) and significantly boost their performance.

語彙:

boost

訳:

さらに重要なことに,RoRはさまざまな種類の残差ネットワーク(ResNet、Pre-ResNet、WRN)に適用できそのパフォーマンスを大幅に向上させることができる。

Our experiments demonstrate the effectiveness and versatility of RoR, where it achieves the best performance in all residual-network-like structures.

語彙:

versatility

訳:

私たちの実験はRoRの有効性と汎用性を実証し,すべての残差ネットワークのような構造で最高のパフォーマンスを達成する。

Our RoR-3-WRN58-4+SD models achieve new state-of-the-art results on CIFAR-10, CIFAR-100 and SVHN, with test errors 3.77%, 19.73% and 1.59%, respectively.

訳:

RoR-3-WRN58-4 + SDモデルはCIFAR-10,CIFAR-100,SVHNでそれぞれ最新のテスト結果を達成し,テストエラーはそれぞれ3.77%,19.73%,1.59%である。

RoR-3 models also achieve state-of-the-art results compared to ResNets on ImageNet data set.

訳: また,RoR-3モデルはImageNetデータセットのResNetと比較して最新の結果を達成する。

12 FractalNet(2016)

原文:

Fractalnet: Ultra-deep neural networks without residuals

Abstract

We introduce a design strategy for neural network macro-architecture based on self-similarity.

語彙:

self-similarity

訳:

自己相似性に基づいたNNマクロアーキテクチャの設計戦略を紹介する。

Repeated application of a simple expansion rule generates deep networks whose structural layouts are precisely truncated fractals.

語彙:

expansion

fractals

訳:

単純な拡張ルールを繰り返し適用することで構造レイアウトが正確に切り捨てられたフラクタルである深いネットワークが生成される。

These networks contain interacting subpaths of different lengths, but do not include any pass-through or residual connections;

every internal signal is transformed by a filter and nonlinearity before being seen by subsequent layers.

語彙:

subpaths

subsequent

訳:

これらのネットワークには長さが異なる相互作用するサブパスが含まれるが,パススルー接続や残差接続は含まれない;

すべての内部信号は後続のレイヤーで表示される前にフィルターと非線形性によって変換される。

In experiments, fractal networks match the excellent performance of standard residual networks on both CIFAR and ImageNet classification tasks, thereby demonstrating that residual representations may not be fundamental to the success of extremely deep convolutional neural networks.

訳:

実験では,フラクタルネットワークはCIFARとImageNetの両方の分類タスクで標準の残差ネットワークの優れたパフォーマンスと一致するため,残差表現は非常に深いCNNの成功の基本ではない可能性がある。

Rather, the key may be the ability to transition, during training, from effectively shallow to deep.

訳:

むしろ,重要なのは学習中に効果的に浅いところから深いところに移行する能力かもしれない。

We note similarities with student-teacher behavior and develop drop-path, a natural extension of dropout, to regularize co-adaptation of subpaths in fractal architectures.

語彙:

note

訳:

学生と教師の行動との類似点に注意し,ドロップアウトの自然な拡張であるドロップパスを開発して,フラクタルアーキテクチャのサブパスの協調適応を正規化します。

Such regularization allows extraction of high-performance fixed-depth subnetworks.

訳:

このような正則化により高性能の深さを固定したサブネットワークを抽出できる。

Additionally, fractal networks exhibit an anytime property:

shallow subnetworks provide a quick answer, while deeper subnetworks, with higher latency, provide a more accurate answer.

語彙:

property

latency

訳:

さらに,フラクタルネットワークはいつでもプロパティを示す:

浅いサブネットワークは迅速な回答を提供し,深いサブネットワークはより高いレイテンシでより正確な回答を提供する。

13 DenseNet(2016)

原文:

Densely connected convolutional networks

Abstract

Recent work has shown that convolutional networks can be substantially deeper, more accurate, and efficient to train if they contain shorter connections between layers close to the input and those close to the output.

訳:

最近の研究によると,畳み込みネットワークは入力に近いレイヤーと出力に近いレイヤー間の接続が短い場合、学習が大幅に深く、より正確で、効率的である。

In this paper, we embrace this observation and introduce the Dense Convolutional Network (DenseNet), which connects each layer to every other layer in a feed-forward fashion.

語彙:

embrace

feed-forward

訳:

本論文では,この観測を取り入れて各層をフィードフォワード方式で他のすべての層に接続するDense Convolutional Network(DenseNet)を紹介する。

Whereas traditional convolutional networks with L layers have L connections - one between each layer and its subsequent layer - our network has L(L+1)/2 direct connections.

語彙:

Whereas

訳:

従来の畳み込みネットワークにはL層に対してL接続ある(各層とその次の層の間に1つ)が,このネットワークにはL(L + 1)/ 2の直接接続がある。

For each layer, the feature-maps of all preceding layers are used as inputs, and its own feature-maps are used as inputs into all subsequent layers.

訳:

各レイヤーについて,先行するすべてのレイヤーの特徴マップが入力として使用され,独自の特徴マップが後続のすべてのレイヤーへの入力として使用される。

DenseNets have several compelling advantages:

they alleviate the vanishing-gradient problem, strengthen feature propagation, encourage feature reuse, and substantially reduce the number of parameters.

語彙:

compelling

alleviate

encourage

訳:

DenseNetにはいくつかの魅力的な利点がある:

消失勾配の問題を緩和し,特徴の伝播を強化し,特徴の再利用を促進し,パラメーターの数を大幅に削減する。

We evaluate our proposed architecture on four highly competitive object recognition benchmark tasks (CIFAR-10, CIFAR-100, SVHN, and ImageNet).

語彙:

competitive

訳:

競争の盛んな4つのオブジェクト認識ベンチマークタスク(CIFAR-10、CIFAR-100、SVHN、およびImageNet)で提案されているアーキテクチャを評価する。

DenseNets obtain significant improvements over the state-of-the-art on most of them, whilst requiring less computation to achieve high performance.

語彙:

whilst

訳:

DenseNetsはそれらのほとんどで最新技術よりも大幅に改善されているながら,高いパフォーマンスを実現するために必要な計算は少なくなっている。

Code and pre-trained models are available at https://github.com/liuzhuang13/DenseNet

訳:

コードと事前トレーニングされたモデルは,https://github.com/liuzhuang13/DenseNetで入手できる。

14 SqueezeNet(2016)

原文:

Squeezenet: Alexnet-level accuracy with 50x fewer parameters and <0.5mb model size

Abstract

Recent research on deep neural networks has focused primarily on improving accuracy.

訳:

DNNに関する最近の研究は主に精度の向上に焦点を当てている。

For a given accuracy level, it is typically possible to identify multiple DNN architectures that achieve that accuracy level.

訳:

指定された精度レベルで,その精度レベルを達成する複数のDNNアーキテクチャを通常識別できる。

With equivalent accuracy, smaller DNN architectures offer at least three advantages:

(1) Smaller DNNs require less communication across servers during distributed training.

(2) Smaller DNNs require less bandwidth to export a new model from the cloud to an autonomous car.

(3) Smaller DNNs are more feasible to deploy on FPGAs and other hardware with limited memory.

語彙:

at least

bandwidth

feasible

訳:

同等の精度で,より小さいDNNアーキテクチャには少なくとも3つの利点がある。

(1)小規模なDNNでは分散トレーニング中のサーバー間の通信が少なくて済む。

(2)小規模なDNNでは新しいモデルをクラウドからautonomous carにエクスポートするために必要な帯域幅が少なくなる。

(3)小規模なDNNはメモリが限られているFPGAやその他のハードウェアに展開するのに適している。

To provide all of these advantages, we propose a small DNN architecture called SqueezeNet.

訳:

これらのすべての利点を提供するために、SqueezeNetと呼ばれる小さなDNNアーキテクチャを提案します。

SqueezeNet achieves AlexNet-level accuracy on ImageNet with 50x fewer parameters.

訳:

SqueezeNetはImageNetでAlexNetレベルの精度を50分の1のパラメーターで達成する。

Additionally, with model compression techniques we are able to compress SqueezeNet to less than 0.5MB (510x smaller than AlexNet).

語彙:

compression

訳:

さらに,モデル圧縮技術によりSqueezeNetを0.5MB未満(AlexNetの510分の1以下)に圧縮できる。

The SqueezeNet architecture is available for download here: https://github.com/DeepScale/SqueezeNet

訳:

SqueezeNetアーキテクチャは、https://github.com/DeepScale/SqueezeNetからダウンロードできる。

15 MobileNet(2017)

原文:

Mobilenets: Efficient convolutional neural networks for mobile vision applications

Abstract

We present a class of efficient models called MobileNets for mobile and embedded vision applications.

語彙:

embedded

訳:

モバイルおよび組み込みビジョンアプリケーション向けのMobileNetと呼ばれるクラスの効率的なモデルを紹介する。

MobileNets are based on a streamlined architecture that uses depth-wise separable convolutions to build light weight deep neural networks.

語彙:

streamlined

訳:

MobileNetは深さ方向に分離可能な畳み込みを使用して軽量のDNNを構築する合理化されたアーキテクチャに基づいている。

We introduce two simple global hyper-parameters that efficiently trade off between latency and accuracy.

訳:

レイテンシと精度を効率的にトレードオフする2つのシンプルなグローバルハイパーパラメーターを導入する。

These hyper-parameters allow the model builder to choose the right sized model for their application based on the constraints of the problem.

訳:

これらのハイパーパラメータによってモデル作成者は問題の制約に基づいてアプリケーションに適したサイズのモデルを選択できる。

We present extensive experiments on resource and accuracy tradeoffs and show strong performance compared to other popular models on ImageNet classification.

語彙:

extensive

訳:

リソースと精度のトレードオフに関する広範な実験を提示しImageNet分類に関する他の一般的なモデルと比較して強力なパフォーマンスを示す。

We then demonstrate the effectiveness of MobileNets across a wide range of applications and use cases including object detection, finegrain classification, face attributes and large scale geo-localization.

語彙:

then

use cases

finegrain

訳:

次に,幅広いアプリケーションでのMobileNetの有効性を実証し,オブジェクト検出,細粒度分類,顔属性,大規模な地理的ローカリゼーションなどのユースケースを紹介する。

次回↓

金匱要略と現代漢方との比較 #8 第17章 嘔吐噦下利病脈證治,第18章 瘡癰腸癰浸淫病脈證并治,第19章 趺蹶手指臂腫轉筋陰狐疝蚘蟲病證治

第17章 嘔吐噦下利病脈證治

嘔吐,噦

状態

夫嘔家有癰膿,不可治嘔,膿盡自愈。先嘔卻渴者,此為欲解;先渴卻嘔者,為水停心下,此屬飲家。嘔家本渴,今反不渴者,以心下有支飲故也,此屬支飲。

胃に癰膿が形成された場合(胃潰瘍に相当?)の嘔吐は,ただ止めるだけではダメで原因の治療が優先される。 嘔吐して口渇が生じるのは生理的な反応である。しかし水飲による嘔吐は胃内停水,口渇のない嘔吐は支飲に相当する。

薬方

呉茱萸湯

嘔而胸滿者,用後方。

右四味,以水五升,煮取三升,溫服七合,日三服。 乾嘔吐涎沫,頭痛者,茱萸湯主之。

成分・分量

- 呉茱萸 3-4

- 大棗 2-4

- 人参 2-3

- 生姜 1-2(ヒネショウガを使用する場合 4-6)

効能・効果

体力中等度以下で、手足が冷えて肩がこり、ときにみぞおちが膨満するものの次の諸症:頭痛、頭痛に伴うはきけ・嘔吐、しゃっくり

解説

冷えを伴う頭痛によく用いられるのだが,この頭痛は胃や肝の寒飲に由来する。呉茱萸には寒邪による逆を鎮める作用がある。

嘔而腸鳴,心下痞者,用後方。

半夏瀉心湯:半夏半升,洗;黃芩、乾姜、人參各三兩;黃連一兩;大棗十二枚;甘草三兩,炙。

右七味,以水一斗,煮取六升,去滓,再煮取三升,溫服一升,日三。

成分・分量

- 半夏 4-6

- 黄芩 2.5-3

- 乾姜 2-3

- 人参 2.5-3

- 甘草 2.5-3

- 大棗 2.5-3

- 黄連 1

効能・効果

体力中等度で、みぞおちがつかえた感じがあり、ときに悪心、 嘔吐があり食欲不振で腹が鳴って軟便又は下痢の傾向のあるものの次の諸症: 急・慢性胃腸炎、下痢・軟便、消化不良、胃下垂、神経性胃炎、 胃弱、二日酔、げっぷ、胸やけ、口内炎、神経症

解説

「みぞおちがつかえた感じ」が鑑別のポイントであり,心または胃の熱と中焦の寒が混じって症状を示す。辛味薬の半夏・乾姜と苦味薬の黄芩・黄連の組み合わせにより寒熱両方に対応する。

四逆湯

嘔而脈弱,小便復利,身有微熱,見厥者難治,用後方。

四逆湯:附子七箇,生用;乾姜一兩半;甘草二兩,炙。

右三味,以水三升,煮取一升二合,去滓,分溫再服。強人可大附子一枚、乾姜三兩。

成分・分量

- 甘草 2-4.8

- 乾姜 1.5-3.6

- 加工ブシ 0.3-2.4

効能・効果

体力虚弱あるいは体力が消耗し、手足が冷えるものの次の諸症:感冒、急・慢性胃腸炎、下痢、はきけ

解説

裏寒,虚脱状態に対して,主に附子や乾姜により内から温めることで対応する。

嘔而發熱者,用後方。

小柴胡湯方:柴胡半斤,黃芩三兩,人參三兩,甘草二兩,半夏半斤,生姜三兩,大棗十二枚。

右七味,以水一斗二升,煮取六升,去滓,再煎取三升,溫服一升,日三。

成分・分量

- 柴胡 5-8

- 半夏 3.5-8

- 生姜 1-2(ヒネショウガを使用する場合3-4)

- 黄芩 2.5-3

- 大棗 2.5-3

- 人参 2.5-3

- 甘草 1-3

効能・効果

体力中等度で、ときに脇腹(腹)からみぞおちあたりにかけて 苦しく、食欲不振や口の苦味があり、舌に白苔がつくものの次の諸症: 食欲不振、はきけ、胃炎、胃痛、胃腸虚弱、疲労感、かぜの後期の諸症状

解説

上焦がつまることにより胸脇苦満や痰飲の形成が生じるとされる。小柴胡湯は長引くかぜなどの寒熱往来に対する代表的処方である。

大半夏湯

胃反嘔吐者,大半夏湯主之。

大半夏湯方:半夏二升,洗完用;人參三兩;白蜜一升。

右三味,以水一斗二升,和蜜揚之二百四十遍,煮取二升半,溫服一升,餘分再服。

成分・分量

- 半夏 7

- 人参 3

- ハチミツ 20

効能・効果

体力中等度以下で、みぞおちがつかえた感じがあるものの次の諸症:嘔吐、むかつき、はきけ、悪心

解説

胃反は発汗により陽気が虚して,胃が虚して冷えたことで嘔吐が生じる状態である。人参・ハチミツにより気を補い,半夏により吐き気を止める構成である。

大黄甘草湯

食已即吐者,用後方。

大黃甘草湯方:大黃四兩,甘草一兩。

右二味,以水三升,煮取一升,分溫再服。

成分・分量

- 大黄 4-10

- 甘草 1-5

用法・用量

(1)散:1 回 0.75-1.5g 1 日 1-2 回

(2)湯

効能・効果

便秘、便秘に伴う頭重・のぼせ・湿疹・皮膚炎・ふきでもの(にきび)・食欲不振(食欲減退)・腹部膨満・腸内異常醗酵・痔などの症状の緩和

《備考》 注)体力に関わらず、使用できる。

解説

食後すぐに吐き出す状態は胃熱に由来すると考えられる。大黄は強力な瀉下・駆瘀血作用を有し,甘草により緩和される。

茯苓沢瀉湯

胃反,吐而渴,欲飲水者,用後方。

茯苓澤瀉湯:茯苓半斤,澤瀉四兩,甘草二兩,桂枝二兩,白朮三兩,生姜四兩。

右六味,以水一斗,煮取三升,內澤瀉,再煮取二升半,溫服八合,日三。

成分・分量

- 茯苓 4-8

- 沢瀉 2.4-4

- 白朮 1.8-3(蒼朮も可)

- 桂皮 1.2-2

- 生姜 1-1.5(ヒネショウガを使用する場合 2.4-4)

- 甘草 1-1.5

効能・効果

体力中等度以下で、胃のもたれ、悪心、嘔吐のいずれかがあり、 渇きを覚えるものの次の諸症:胃炎、胃腸虚弱

解説

脾胃虚損による嘔吐・口渇に適応する。

下痢

状態

夫六府氣絕於外者,手足寒,上氣腳縮;五臟氣絕於內者,利不禁,下甚者,手足不仁。

六腑の気が絶えると手足の冷えや嘔吐を生じ,五臓の気が絶えると下痢や手足の痺れが生じる。

薬方

四逆湯(第17章嘔吐,噦解説済み)

桂枝湯

下利,腹脹滿,身體疼痛者,先溫其裏,乃攻其表。溫裏宜四逆湯,攻表宜桂枝湯。

桂枝三兩,去皮;芍藥三兩;甘草三兩,炙;生姜三兩;大棗十二枚。

右五味,㕮咀,以水七升,微火煮取三升,去滓,適寒溫,服一升。服已,須臾,啜稀粥一升,已助藥力,溫覆令一時許,遍身熱熱微似有汗者益佳,不可令如水淋漓。若一服汗出病差,停後服。

成分・分量

- 桂皮 3-4

- 芍薬 3-4

- 大棗 3-4

- 生姜 1-1.5(ヒネショウガを使用する場合 3-4)

- 甘草 2

効能・効果

体力虚弱で、汗が出るものの次の症状: かぜの初期

解説

傷寒論にも同様の記述がある。厥陰において表裏の証が混在している場合は,まず四逆湯で裏を温めて,その後表を散ずるために桂枝湯を用いる。

大承気湯(第2章解説済み)

下利三部脈皆平,按之心下堅者,急下之,宜大承湯。

下利脈遲而滑者,實也。利未欲止,急下之,宜大承氣湯。

下利脈反滑者,當有所去,下乃愈,宜大承氣湯。

下利已差,至其年月日時復發者,以病不盡故也,當下之,宜大承氣湯。

小承気湯

下利譫語者,有燥屎也,小承氣湯主之。

大黃四兩;厚朴二兩,炙;枳實大者三枚,炙。

右三味,以水四升,煮取一升二合,去滓,分溫二服,得利則止。

《千金翼》小承氣湯:治大便不通,噦,數譫語。

成分・分量

- 大黄 2-4

- 枳実 2-4

- 厚朴 2-3

効能・効果

比較的体力があり、腹部が張って膨満し、ときに発熱するものの次の症状: 便秘

解説

熱により津液が喪失して便秘になる一方で,大便からの津液が下降することで下痢が生じることもある。大承気湯から芒硝を除き枳実・厚朴を減量した構成である。

第18章 瘡癰腸癰浸淫病脈證并治

瘡癰

状態

諸浮數脈,應當發熱,而反洒浙惡寒,若有痛處,當發其癰。

瘡癰は皮膚疾患で特に化膿性のものを指す。後に出てくる腸癰は急性虫垂炎や化膿性腸炎を指す。

薬方

薏苡附子敗醤散

腸癰之為病,其身甲錯,腹皮急,按之濡如腫狀,腹無積飛,身而熱,脈數,此為膿內有癰膿,薏苡附子敗醬散主之。

薏苡附子敗醬散方:薏苡仁十分,附子二分,敗醬五分。

右三味,杵為末,取方寸匕,以水二升,煎減半,頓服,小便當下。

成分・分量

- 薏苡仁 1-16

- 加工ブシ 0.2-2

- 敗醤 0.5-8

効能・効果

体力虚弱なものの次の諸症:熱を伴わない下腹部の痛み、湿疹・皮膚炎、肌あれ、いぼ

解説

慢性の化膿性疾患により皮膚が栄養不足となり肌荒れが生じた状態に適応する。薏苡仁・敗醤は清熱作用があり排膿にはたらく。

大黄牡丹皮湯

腸癰者,小腹腫痞,按之即痛如淋,小便自調,時時發熱,自汗出,復惡寒。其脈遲緊者,膿未成,可下之,當有血。脈洪數者,膿已成,不可下也,大黃牡丹湯主之。

大黃牡丹湯方:大黃四兩,牡丹一兩,桃仁五十箇,瓜子半升,芒消三合。

右五味,以水六升,煮取一升,去滓,內芒消再煎沸,頓服之,有膿當下,如先膿,當下血。

成分・分量

- 大黄 1-5

- 牡丹皮 1-4

- 桃仁 2-4

- 芒硝 3.6-4

- 冬瓜子 2-6

効能・効果

体力中等度以上で、下腹部痛があって、便秘しがちなものの次の諸症:月経不順、月経困難、月経痛、便秘、痔疾

解説

脈洪数のときは熱が盛んで陰虚が生じており,瀉下薬を用いてはいけない。大黄牡丹皮湯には排膿・駆瘀血作用がある。

排膿散

排膿散方:枳實十六枚,芍藥六分,桔梗一分。

右三味,杵為散,取雞子黃一枚,以藥散與雞黃相等,揉和。

成分・分量

- 枳実 3-10

- 芍薬 3-6

- 桔梗 1.5-2

- 卵黄 1 個(卵黄はない場合も可)

用法・用量

(1)散:1 回 1.5-4g 1 日 1-2 回

(2)湯(卵黄ははぶくのが普通)生薬を細末とし 1 回量 2-3g に卵黄を加えて、よく攪拌し白湯にて服す。1 日 1-2 回頓服として用いる。

効能・効果

体力中等度以上で、患部が化膿するものの次の諸症: 化膿性皮膚疾患の初期又は軽いの、歯肉炎、扁桃炎

解説

枳実・桔梗が気血や熱の鬱滞を除き,桔梗が排膿にはたらく。

排膿湯

排膿湯方:甘草二両,桔梗三両,生姜一両,大棗十枚。

右四味,以水三升,煮取一升,温服五合,日再服。

成分・分量

- 甘草 1.5-3

- 桔梗 1.5-5

- 生姜 0.5-1(ヒネショウガを使用する場合 1-3)

- 大棗 2.5-6

効能・効果

体力中等度以下で、患部が化膿するものの次の諸症: 化膿性皮膚疾患・歯肉炎・扁桃炎の初期または軽いもの

解説

瘡癰が長引いて営衛が虚損した状態に用いられる。

第19章 趺蹶手指臂腫轉筋陰狐疝蚘蟲病證治

状態

師曰:病趺蹶,其人但能前不能卻,刺腨入二寸,此太陽經傷也。 病人常以手指臂腫動,此人身體瞤瞤者,蔾蘆甘草湯主之。 轉筋之為病,其人臂腳直,脈上下行,微弦,轉筋入腹者,雞屎白散主之。 陰狐疝氣者,偏有小大,時時上下,蜘蛛散主之。 問曰:病腹痛有虫,其脈何以別之?師曰:腹中痛,其脈當沉,若弦,反洪大,故有蚘蟲。

- 跌蹶:足の運動機能の異常

- 手指臂腫:手指から腕にかけての腫れ

- 転筋:筋肉の痙攣

- 陰狐疝:鼠径ヘルニア

- 蚘虫:回虫病

次回↓

論文Abstract100本ノック#2

前回↓

※変更点

表記:単語→語彙

6 SENet(2017)

原文:

Squeeze-and-excitation networks

Abstract

The central building block of convolutional neural networks (CNNs) is the convolution operator, which enables networks to construct informative features by fusing both spatial and channel-wise information within local receptive fields at each layer.

訳:

畳み込みニューラルネットワーク(CNN)の中心的な構成要素は畳み込み演算子であり,これによりネットワークは各層の局所受容野内で空間情報とチャネルごとの情報の両方を融合することによって有益な機能を構築できる。

A broad range of prior research has investigated the spatial component of this relationship, seeking to strengthen the representational power of a CNN by enhancing the quality of spatial encodings throughout its feature hierarchy.

語彙:

prior research

relationship

spatial

訳:

広範囲の先行研究がこの関係の空間コンポーネントを調査し,その機能階層全体で空間エンコーディングの品質を向上させることによりCNNの表現力を強化しようとしている。

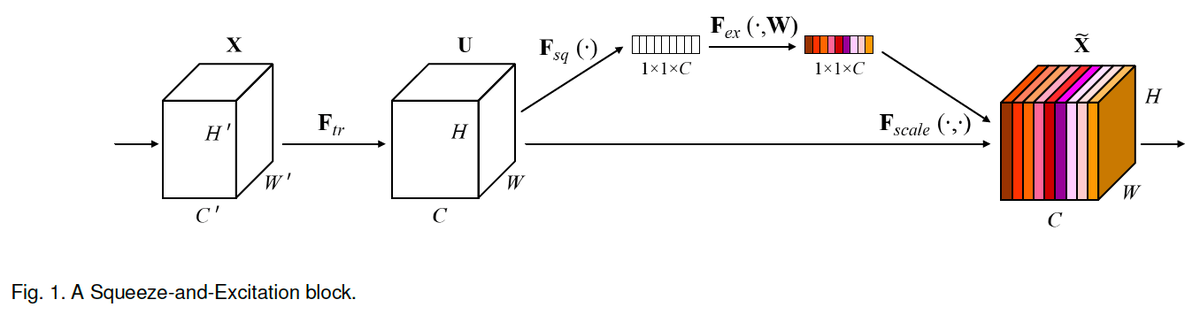

In this work, we focus instead on the channel relationship and propose a novel architectural unit, which we term the “Squeeze-and-Excitation” (SE) block, that adaptively recalibrates channel-wise feature responses by explicitly modelling interdependencies between channels.

語彙:

instead

Squeeze

Excitation

interdependencies

訳:

ここでは代わりにチャネル関係に焦点を当て,チャネル間の相互依存関係を明示的にモデル化することでチャネルごとの機能応答を適応的に再調整する,「Squeeze-and-Excitation」(SE)ブロックと呼ばれる新しいアーキテクチャユニットを提案する。

We show that these blocks can be stacked together to form SENet architectures that generalise extremely effectively across different datasets.

訳:

これらのブロックを積み重ねて異なるデータセットで非常に効果的に一般化するSENetアーキテクチャを形成できることを示す。

We further demonstrate that SE blocks bring significant improvements in performance for existing state-of-the-art CNNs at slight additional computational cost.

語彙:

slight

訳:

さらに,SEブロックがわずかな追加の計算コストで、既存の最先端CNNのパフォーマンスを大幅な向上をもたらすことを示す。

Squeeze-and-Excitation Networks formed the foundation of our ILSVRC 2017 classification submission which won first place and reduced the top-5 error to 2.251%, surpassing the winning entry of 2016 by a relative improvement of ∼25%.

訳:

Squeeze-and-Excitation NetworksはILSVRC 2017分類課題の基礎を形成し1位を獲得し,トップ5エラーを2.251%に減らし,2016年の入賞エントリを~25%の相対的な改善で上回った。

Models and code are available at https://github.com/hujie-frank/SENet.

語彙:

available

訳: モデルとコードはhttps://github.com/hujie-frank/SENetで利用可能である。

7 WideResNet(2016)

原文:

Abstract

Deep residual networks were shown to be able to scale up to thousands of layers and still have improving performance.

訳:

深い残差ネットワークは数千のレイヤーにスケールアップできパフォーマンスが改善されることが示された。

However, each fraction of a percent of improved accuracy costs nearly doubling the number of layers, and so training very deep residual networks has a problem of diminishing feature reuse, which makes these networks very slow to train.

語彙:

percent

diminishing

reuse

訳:

しかし,精度の向上の割合の一部はレイヤー数をほぼ2倍にすることにあり,非常に深い残差ネットワークの学習には機能の再利用が減少するという問題があり,これらのネットワークの学習は非常に遅くなる。

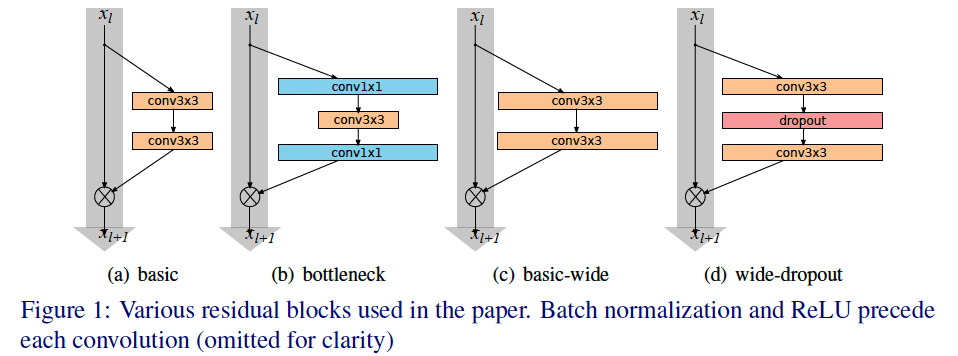

To tackle these problems, in this paper we conduct a detailed experimental study on the architecture of ResNet blocks, based on which we propose a novel architecture where we decrease depth and increase width of residual networks.

語彙:

tackle these problems

conduct

based on

訳:

これらの問題に取り組むために,本論文ではResNetブロックのアーキテクチャに関する詳細な実験的研究を実施し,それに基づいて残差ネットワークの深さを減らし幅を広げる新しいアーキテクチャを提案する。

We call the resulting network structures wide residual networks (WRNs) and show that these are far superior over their commonly used thin and very deep counterparts.

語彙:

thin

counterparts

訳:

結果のネットワーク構造をwide residual networks(WRN)と呼び,これらが一般的に使用される薄く非常に深い対照のものよりもはるかに優れていることを示す。

For example, we demonstrate that even a simple 16-layer-deep wide residual network outperforms in accuracy and efficiency all previous deep residual networks, including thousand-layerdeep networks, achieving new state-of-the-art results on CIFAR, SVHN, COCO, and significant improvements on ImageNet.

訳:

たとえば,単純な16層の深さのWRNでも1000層の深さのネットワークを含む以前のすべての深層残差ネットワークの精度と効率が優れていることを実証しており,CIFAR,SVHN,COCOの最新の結果を達成しImageNetの大幅な更新を示している。

Our code and models are available at https://github.com/szagoruyko/wide-residual-networks.

語彙:

訳:コードとモデルは,https://github.com/szagoruyko/wide-residual-networksで入手できる。

8 PyramidNet(2016)

原文:

Deep pyramidal residual networks

Abstract

Deep convolutional neural networks (DCNNs) have shown remarkable performance in image classification tasks in recent years.

語彙:

remarkable

訳:

DCNNは近年の画像分類タスクで顕著なパフォーマンスを示している。

Generally, deep neural network architectures are stacks consisting of a large number of convolutional layers, and they perform downsampling along the spatial dimension via pooling to reduce memory usage.

単語:

downsampling

訳:

一般に,DNNアーキテクチャは多数の畳み込み層で構成されるスタックであり,メモリ使用量を削減するためにプーリングを介して空間次元に沿ってダウンサンプリングを実行する。

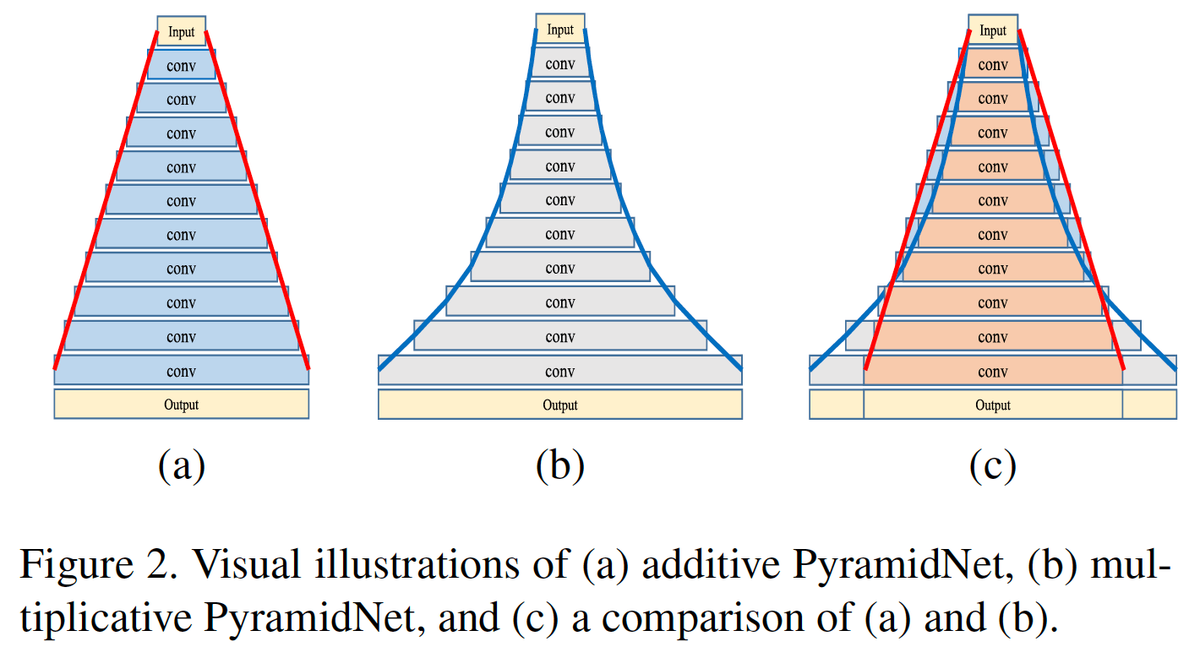

Concurrently, the feature map dimension (i.e., the number of channels) is sharply increased at downsampling locations, which is essential to ensure effective performance because it increases the diversity of high-level attributes.

語彙:

Concurrently

i.e.

essential

diversity

訳:

同時に,機能マップの次元(つまりチャネル数)はダウンサンプリング位置で急激に増加する,これは高レベルの属性の多様性を高めるため効果的なパフォーマンスを確保するために不可欠です。

This also applies to residual networks and is very closely related to their performance.

訳:

これは残差ネットワークにも適用され,それらのパフォーマンスに非常に密接に関連している。

In this research, instead of sharply increasing the feature map dimension at units that perform downsampling, we gradually increase the feature map dimension at all units to involve as many locations as possible.

語彙:

feature map

gradually

訳:

この研究では,ダウンサンプリングを実行するユニットで特徴マップの次元を大幅に増やす代わりに,できるだけ多くの場所を含むようにすべてのユニットで特徴マップの次元を徐々に増やす。

This design, which is discussed in depth together with our new insights, has proven to be an effective means of improving generalization ability.

語彙:

insights

訳:

この設計は,新しい洞察とともに詳細に説明されており,一般化能力を向上させる効果的な手段であることが証明されている。

Furthermore, we propose a novel residual unit capable of further improving the classification accuracy with our new network architecture.

訳:

さらに,新しいネットワークアーキテクチャで分類精度をさらに向上させることができる新しい残差ユニットを提案する。

Experiments on benchmark CIFAR-10, CIFAR-100, and ImageNet datasets have shown that our network architecture has superior generalization ability compared to the original residual networks.

語彙:

Experiments

訳:

ベンチマークCIFAR-10、CIFAR-100、およびImageNetデータセットの実験にて,ネットワークアーキテクチャが元の残差ネットワークと比較して優れた一般化能力を持っていることが示された。

Code is available at https://github.com/jhkim89/PyramidNet.

訳: コードはhttps://github.com/jhkim89/PyramidNetで入手できる。

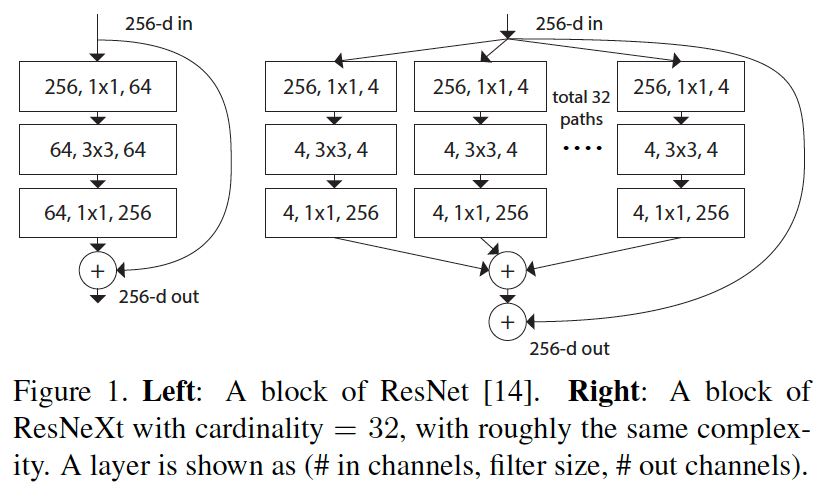

9 ResNeXt(2016)

原文:

Aggregated residual transformations for deep neural networks

Abstract

We present a simple, highly modularized network architecture for image classification.

訳:

画像分類のためのシンプルで高度にモジュール化されたネットワークアーキテクチャを紹介する。

Our network is constructed by repeating a building block that aggregates a set of transformations with the same topology.

語彙:

aggregates

訳:

ネットワークは同じトポロジーで一連の変換を集約するビルディングブロックを繰り返すことで構築される。

Our simple design results in a homogeneous, multi-branch architecture that has only a few hyper-parameters to set.

語彙:

homogeneous

multi-branch

訳:

シンプルな設計によって,設定するハイパーパラメーターがわずかな均質な分岐アーキテクチャが実現する。

This strategy exposes a new dimension, which we call "cardinality" (the size of the set of transformations), as an essential factor in addition to the dimensions of depth and width.

語彙:

exposes

cardinality

訳:

この戦略は深さと幅の次元に加えて,重要な要素として「cardinality」(変換セットのサイズ)と呼ばれる新しい次元を導入する。

On the ImageNet-1K dataset, we empirically show that even under the restricted condition of maintaining complexity, increasing cardinality is able to improve classification accuracy.

語彙:

empirically

even under

訳:

ImageNet-1Kデータセットで,複雑さを維持するという制限された条件下でも,cardinalityを増加させると分類精度が向上することが経験的に示されている。

Moreover, increasing cardinality is more effective than going deeper or wider when we increase the capacity.

訳:

さらに,容量を増やすときにcardinalityを増やすことは深くまたは広くするよりも効果的である。

Our models, named ResNeXt, are the foundations of our entry to the ILSVRC 2016 classification task in which we secured 2nd place.

訳:

ResNeXtと名付けられたこのモデルは,2位を獲得したILSVRC 2016分類タスクへのエントリーの基盤である。

We further investigate ResNeXt on an ImageNet-5K set and the COCO detection set, also showing better results than its ResNet counterpart.

語彙:

investigate

訳:

ImageNet-5KセットおよびCOCO検出セットでResNeXtをさらに調査し、ResNetよりも良い結果を示している。

The code and models are publicly available online.

訳:

コードとモデルはオンラインで公開されている。

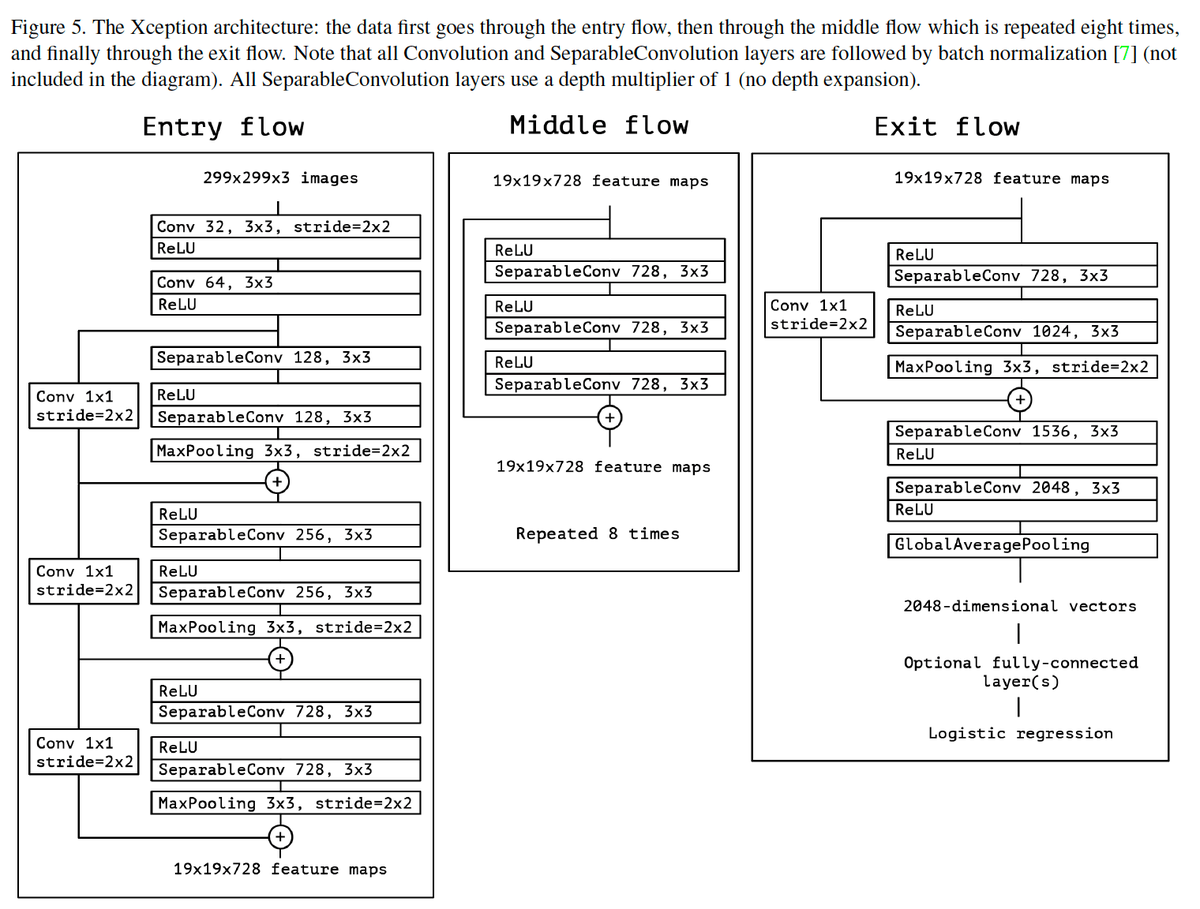

10 Xception(2016)

原文:

Xception: Deep learning with depthwise separable convolutions

Abstract

We present an interpretation of Inception modules in convolutional neural networks as being an intermediate step in-between regular convolution and the depthwise separable convolution operation (a depthwise convolution followed by a pointwise convolution).

語彙:

interpretation

intermediate

訳:

CNNのInceptionモジュールの解釈について,通常の畳み込みと深さ方向に分離可能な畳み込み操作(深さ方向の畳み込みに続いて点ごとの畳み込み)の中間ステップとして提示する。

In this light, a depthwise separable convolution can be understood as an Inception module with a maximally large number of towers.

語彙:

In this light

訳:

この観点から,深さ方向に分離可能な畳み込みは最大数の段を持つInceptionモジュールとして理解できる。

This observation leads us to propose a novel deep convolutional neural network architecture inspired by Inception, where Inception modules have been replaced with depthwise separable convolutions.

語彙:

leads us to

inspired

訳:

この観察に基づいて,Inceptionにインスパイアされた新しいDCNNアーキテクチャを提案する,ここでInceptionモジュールは深さ方向に分離可能な畳み込みに置き換えられている。

We show that this architecture, dubbed Xception, slightly outperforms Inception V3 on the ImageNet dataset (which Inception V3 was designed for), and significantly outperforms Inception V3 on a larger image classification dataset comprising 350 million images and 17,000 classes.

語彙:

dubbed

slightly

outperforms

significantly

訳:

Xceptionと呼ばれるこのアーキテクチャは,ImageNetデータセット(Inception V3の設計対象)でInception V3をわずかに上回り,3億5千万の画像と17,000のクラスで構成される大きな画像分類データセットでInception V3を大幅に上回ることを示す。

Since the Xception architecture has the same number of parameters as Inception V3, the performance gains are not due to increased capacity but rather to a more efficient use of model parameters.

語彙:

not ~ but rather to -

訳:

XceptionアーキテクチャにはInception V3と同じ数のパラメーターがあるため,パフォーマンスの向上は容量の増加によるものではなくモデルパラメーターのより効率的な使用によるものである。

次回↓

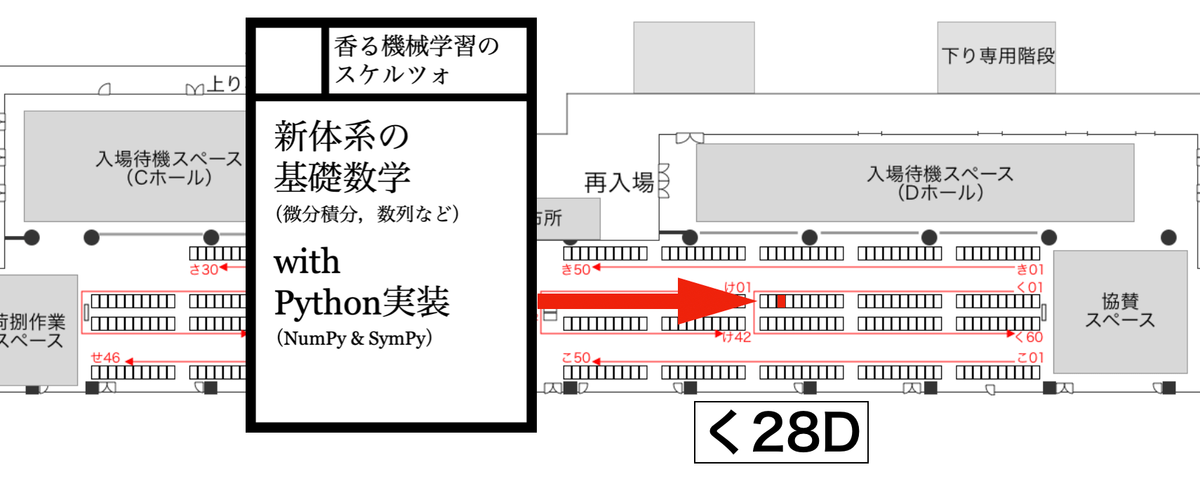

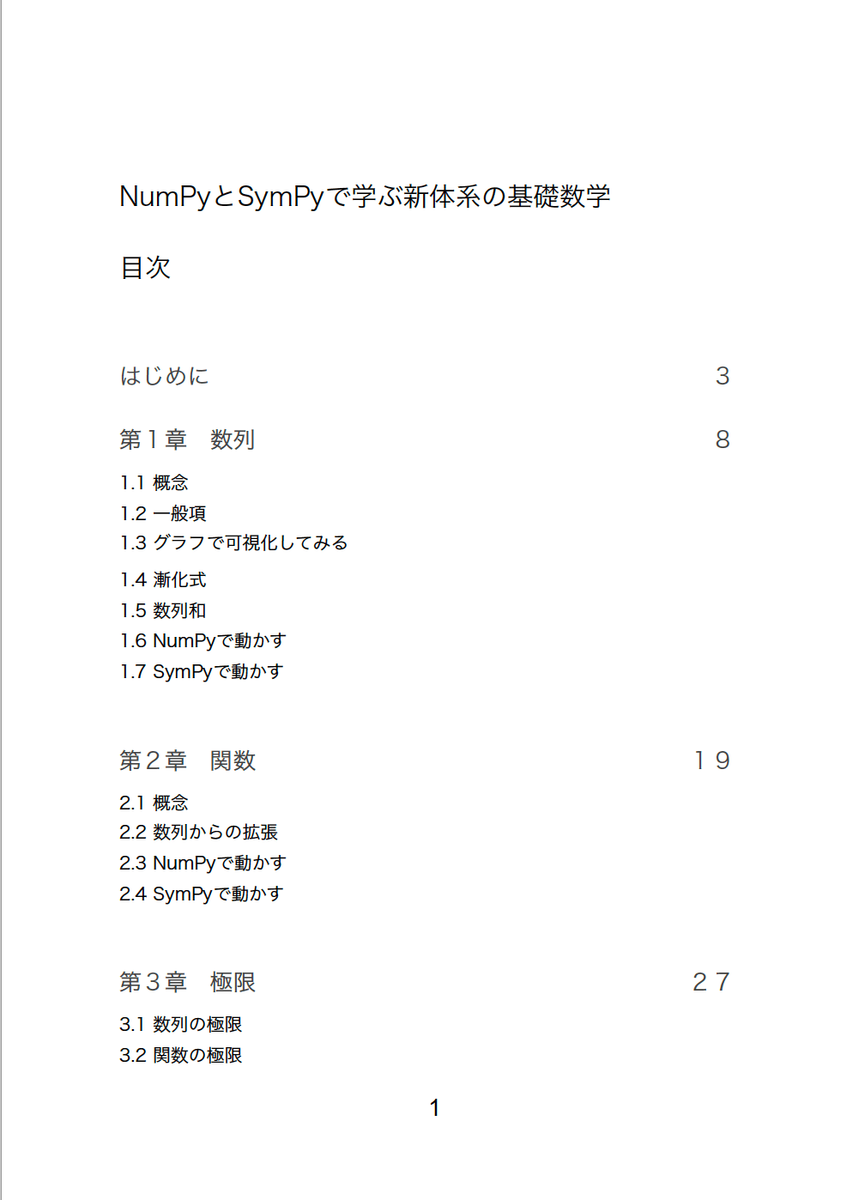

技術書典7で技術書「NumPyとSymPyで学ぶ新体系の基礎数学」を頒布します

技術書典7について概要

公式:

https://techbookfest.org/event/tbf07

技術書典とは?(公式hpより)

新しい技術に出会えるお祭りです。 技術書典は、いろんな技術の普及を手伝いたいとの想いではじまりました。 技術書を中心として出展者はノウハウを詰め込み、来場者はこの場にしかないおもしろい技術書をさがし求める、技術に関わる人のための場として『技術書典』を開催します。

ようは技術書を通してワイワイやろうという感じのイベントで,周囲の誘いにより私も技術書を執筆・頒布することとなった。

サークル,本の大まかな内容

サークル

場所:く28D(2階にあります)

サークル詳細ページ:

https://techbookfest.org/event/tbf07/circle/5767995578122240

本

頒布物:「NumPyとSymPyで学ぶ新体系の基礎数学」

はじめに より

本書は機械学習や統計学などの基礎として,最低限知っておくべき数学についてまとめたものである。内容としては,高校数学のうち大学でいう解析学につながるような部分を一通り網羅した(微分方程式は大学数学の範囲だが漸化式の延長として導入した)。また本書では,Pythonの基本的なライブラリであるNumPy,Matplotlibに加えて,記号演算が手軽にできるSymPyを用いての実装も行う。

「統計学や機械学習が必要になった,勉強したい,だけど数学がわからない,で何で勉強すればいいの?」

こういった問いに答える形で執筆した。基本的には高校数学レベルの知識が要されることが多い,しかしただやみくもに問題を解くだけではダメで,「なぜそうなるのか」を理解する必要がある(ex.微分ってなんであの公式なの?積分って結局何してるの?)。

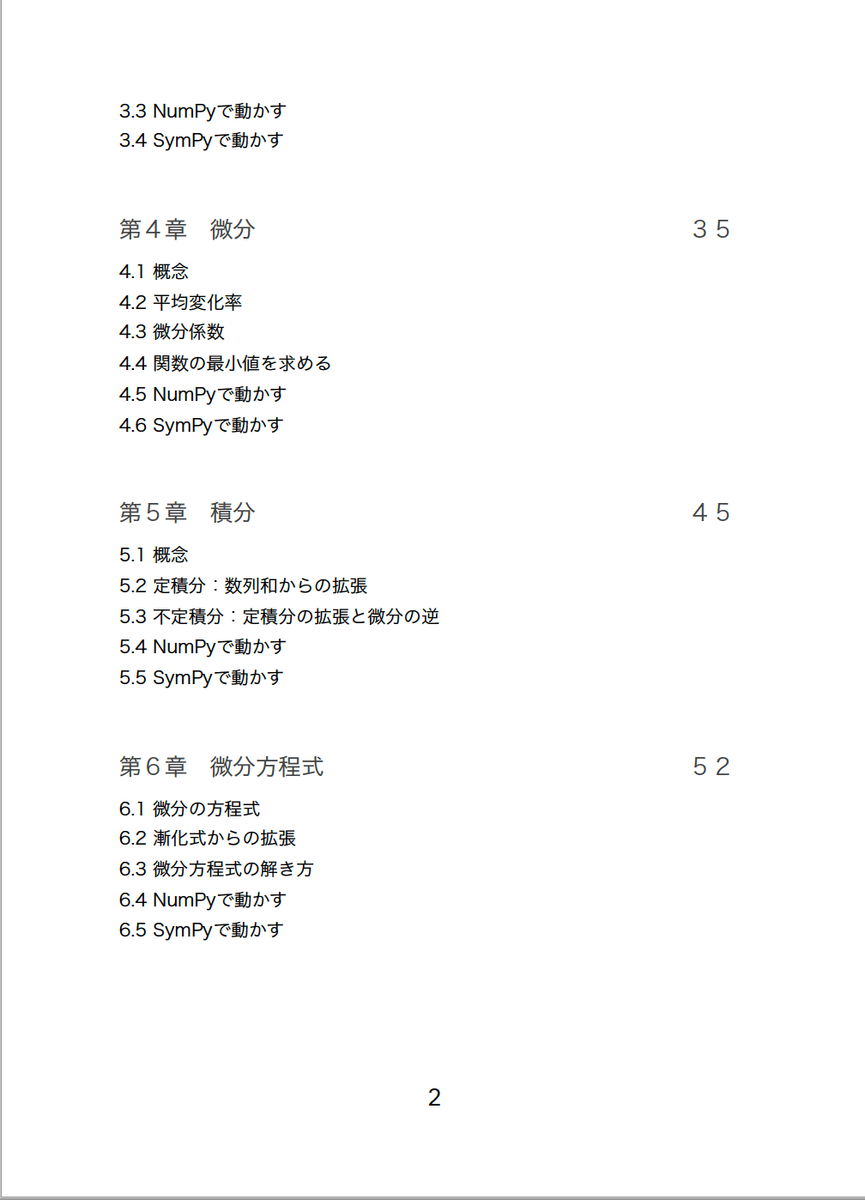

本書は高校数学レベルの内容を見通しよく理解するため,「離散から連続へ」をテーマにまとめ直したものとなっている。下図にそのマッピングを示す。

さらに,理論の説明だけでなくPythonによる簡単な実装も収録している。Google Colaboratoryで動かすので,環境構築はラクにできると思う。

参考:Google Colaboratoryの環境構築について

まとめ

興味のある方は,ぜひ技術書典7にお越しいただけたらと思います。私も「技術」を通していろいろ楽しみたいと思います。

論文Abstract100本ノック#1

本記事の進行について

以前,論文の要約をしようと以下の記事を作成公開した。

それで思った

「もうAbstractだけ読めば良くね?」

本記事では,論文をとにかく「多読」する目的で,Abstractだけを訳してみる。世にはびこる速読論にならうわけではないが,読解の基本は要点を押さえることにある。論文の場合,大事なことはだいたいAbstractにまとめられているので,そこだけ読んで何となくの立ち位置を知ろう,といった感じだ。

方針として,単語と訳を載せる。

単語では,文章中で気になった,重要そうな単語をピックアップして列挙する。単語訳については後日別記事に書く予定である。

訳では,Abstractを1文ずつ区切って日本語訳する。現地点での筆者は見ただけで訳せるほどの英語力はないので,Google翻訳を活用する。完全に依存する訳ではなくアウトライン把握のためであり,不自然と感じた文章は訂正するよう努力する。

まずは下記事を参考にして,画像認識に関する論文を読んでいく。

1. AlexNet(2012)

原文:

ImageNet Classification with Deep Convolutional Neural Networks

We trained a large, deep convolutional neural network to classify the 1.2 million high-resolution images in the ImageNet LSVRC-2010 contest into the 1000 different classes.

単語:

convolutional neural network

訳:

ImageNet LSVRC-2010コンテストの120万の高解像度画像を1000の異なるクラスに分類するために,大規模で深い畳み込みニューラルネットワークを学習させた。

On the test data, we achieved top-1 and top-5 error rates of 37.5% and 17.0% which is considerably better than the previous state-of-the-art.

単語:

state-of-the-art

訳:

テストデータではトップ1およびトップ5エラー率37.5%および17.0%を達成しており,これは従来の最新技術よりもかなり優れている。

The neural network, which has 60 million parameters and 650,000 neurons, consists of five convolutional layers, some of which are followed by max-pooling layers, and three fully-connected layers with a final 1000-way softmax.

単語:

parameters

neurons

訳:

6000万のパラメーターと65万のニューロンを持つニューラルネットワークは,5つの畳み込み層で構成され,いくつかのMaxプーリング層があり,最後に1000個のソフトマックスを持つ3つの全結合層が続く。

To make training faster, we used non-saturating neurons and a very efficient GPU implementation of the convolution operation.

単語:

saturating

訳:

学習を高速化するために,非飽和ニューロンと畳み込み演算の非常に効率的なGPU実装を使用した。

To reduce overfitting in the fully-connected layers we employed a recently-developed regularization method called “dropout” that proved to be very effective.

単語:

overfitting

regularization

dropout

訳:

全結合層の過学習を減らすために,非常に効果的であることが証明された「ドロップアウト」と呼ばれる最近開発された正則化を採用した。

We also entered a variant of this model in the ILSVRC-2012 competition and achieved a winning top-5 test error rate of 15.3%, compared to 26.2% achieved by the second-best entry.

単語:

variant

訳:

またILSVRC-2012コンテストでこのモデルの類型をエントリーし,2位のエントリーで達成された26.2%と比較して,15.3%のトップ5テストエラー率を達成した。

2. ZFNet(2013)

原文:

Visualizing and understanding convolutional networks

Large Convolutional Network models have recently demonstrated impressive classification performance on the ImageNet benchmark (Krizhevsky et al., 2012).

訳:

最近,大規模な畳み込みネットワークモデルはImageNetベンチマークで印象的な分類性能を実証した(Krizhevsky et al., 2012※AlexNetのこと)。

However there is no clear understanding of why they perform so well, or how they might be improved.

訳:

ただしそれらがなぜそれほどうまく機能するのか,またはどのように改善されるのかについての明確な理解はない。

In this paper we address both issues.

訳:

本論文では両方の問題に対処する。

We introduce a novel visualization technique that gives insight into the function of intermediate feature layers and the operation of the classifier.

単語:

introduce

訳:

intermediate feature layersの機能と分類器の動作についての洞察を提供する,新しい視覚化手法を紹介する。

Used in a diagnostic role, these visualizations allow us to find model architectures that outperform Krizhevsky et al. on the ImageNet classification benchmark.

単語:

diagnostic

訳:

診断の役割で使用されるこれらの視覚化により,ImageNet分類ベンチマークにてKrizhevskyらを上回るモデルアーキテクチャを見つけることができる。

We also perform an ablation study to discover the performance contribution from different model layers.

単語:

ablation study

訳:

また、さまざまなモデルレイヤーからのパフォーマンスへの影響を見つけるために,ablation studyを実行する。

We show our ImageNet model generalizes well to other datasets: when the softmax classifier is retrained, it convincingly beats the current state-of-the-art results on Caltech-101 and Caltech-256 datasets.

訳: ImageNetモデルが他のデータセットに一般化されていることを示す:softmax分類器が再学習されると、Caltech-101およびCaltech-256データセットに関する現在の最先端の結果を確実に打ち負かす。

3. GoogLeNet(2014)

原文:

Going deeper with convolutions

We propose a deep convolutional neural network architecture codenamed "Inception", which was responsible for setting the new state of the art for classification and detection in the ImageNet Large-Scale Visual Recognition Challenge 2014 (ILSVRC 2014).

単語:

propose

Inception

訳:

ImageNet Large-Scale Visual Recognition Challenge 2014(ILSVRC 2014)で分類と検出の新しい最先端を設定する役割を担った「Inception」というコード名のCNNアーキテクチャを提案する。

The main hallmark of this architecture is the improved utilization of the computing resources inside the network.

単語:

hallmark

訳:

このアーキテクチャの主な特徴は、ネットワーク内のコンピューティングリソースの利用率の向上である。

This was achieved by a carefully crafted design that allows for increasing the depth and width of the network while keeping the computational budget constant.

訳:

これは計算の予算を一定に保ちながら,ネットワークの深さと幅を増やすことができる,慎重に作成された設計によって実現された。

To optimize quality, the architectural decisions were based on the Hebbian principle and the intuition of multi-scale processing.

単語:

Hebbian principle

multi-scale processing

訳:

品質を最適化するために,アーキテクチャ上の決定はヘブ則とマルチスケール処理の直感に基づいた。

One particular incarnation used in our submission for ILSVRC 2014 is called GoogLeNet, a 22 layers deep network, the quality of which is assessed in the context of classification and detection.

訳: ILSVRC2014の提出で使用されたモデルはGoogLeNetと呼ばれ、22層の深さのネットワークであり、その品質は分類と検出のコンテキストで評価される。

4. VGGNet(2014)

原文:

Very deep convolutional networks for large-scale image recognition

In this work we investigate the effect of the convolutional network depth on its accuracy in the large-scale image recognition setting.

単語:

investigate

depth

訳:

ここでは,大規模な画像認識設定における畳み込みネットワークの深さがその精度に及ぼす影響を調査する。

Our main contribution is a thorough evaluation of networks of increasing depth using an architecture with very small (3x3) convolution filters, which shows that a significant improvement on the prior-art configurations can be achieved by pushing the depth to 16-19 weight layers.

単語:

contribution

訳:

私たちの主な貢献は,非常に小さい(3x3)畳み込みフィルターを備えたアーキテクチャを使用して深さの増加するネットワークを徹底的に評価することであり,ここでは深さを16〜19の重量層に押し上げることで従来の構成の大幅な改善を実現できることを示している。

These findings were the basis of our ImageNet Challenge 2014 submission, where our team secured the first and the second places in the localisation and classification tracks respectively.

単語:

localisation

classification

訳:

これらの調査結果は、ImageNet Challenge 2014の提出の基礎となった,ここで私たちのチームはlocalisationトラックとclassificationトラックでそれぞれ1位と2位を獲得した。

We also show that our representations generalise well to other datasets, where they achieve state-of-the-art results.

単語:

representations

訳:

私たちの表現(考え方)が他のデータセットに一般化され,最新の結果が得られることも示している。

We have made our two best-performing ConvNet models publicly available to facilitate further research on the use of deep visual representations in computer vision.

単語:

facilitate

further

訳:

コンピュータービジョンでの深い視覚表現の使用に関するさらなる研究を推進するために,2つの最高のパフォーマンスのConvNetモデルを公開した。

5. ResNet(2015)

原文:

Deep residual learning for image recognition

Deeper neural networks are more difficult to train.

訳:

より深いニューラルネットワークは学習がより困難である。

We present a residual learning framework to ease the training of networks that are substantially deeper than those used previously.

単語:

present

residual

訳:

以前に使用されたものよりかなり深いネットワークの学習を容易にするための残差学習フレームワークを提示する。

We explicitly reformulate the layers as learning residual functions with reference to the layer inputs, instead of learning unreferenced functions.

単語:

explicitly

reference

訳:

参照されていない関数を学習する代わりに,レイヤー入力を参照して残差関数を学習するようにレイヤーを明示的に再定式化する。

We provide comprehensive empirical evidence showing that these residual networks are easier to optimize, and can gain accuracy from considerably increased depth.

訳:

これらの残差ネットワークは最適化が容易であり,深さが大幅に増加すると精度が上がることを示す包括的な経験的証拠を提供する。

On the ImageNet dataset we evaluate residual nets with a depth of up to 152 layers---8x deeper than VGG nets but still having lower complexity.

訳:

ImageNetデータセットでは最大152レイヤーの深さの残差ネットを評価する。これはVGGネットの8倍の深さだが複雑さは低くなっている。

An ensemble of these residual nets achieves 3.57% error on the ImageNet test set.

訳:

これらの残差ネットのアンサンブルはImageNetテストセットで3.57%のエラーを達成した。

This result won the 1st place on the ILSVRC 2015 classification task.

訳:

この結果によりILSVRC 2015 classificationタスクで1位になった。

We also present analysis on CIFAR-10 with 100 and 1000 layers.

訳:

また100および1000層のCIFAR-10の分析も示す。

The depth of representations is of central importance for many visual recognition tasks.

単語:

of central importance

訳:

表現の深さは多くの視覚認識タスクにとって最も重要である。

Solely due to our extremely deep representations, we obtain a 28% relative improvement on the COCO object detection dataset.

単語:

Solely

訳:

表現が非常に深いことだけで,COCOオブジェクト検出データセットで28%の相対的な改善が得られています。

Deep residual nets are foundations of our submissions to ILSVRC & COCO 2015 competitions, where we also won the 1st places on the tasks of ImageNet detection, ImageNet localization, COCO detection, and COCO segmentation.

単語:

foundations

訳: 深い残差ネットはILSVRC&COCO 2015コンテストへの提出の基礎であり,ImageNet検出,ImageNetローカリゼーション,COCO検出,およびCOCOセグメンテーションのタスクで1位を獲得した。

次回↓

作成中