確率・統計の勉強 #12(最終回) 最尤推定からクラメール・ラオの不等式まで

藤田 岳彦「弱点克服大学生の確率・統計」:

前回↓

問題

解法

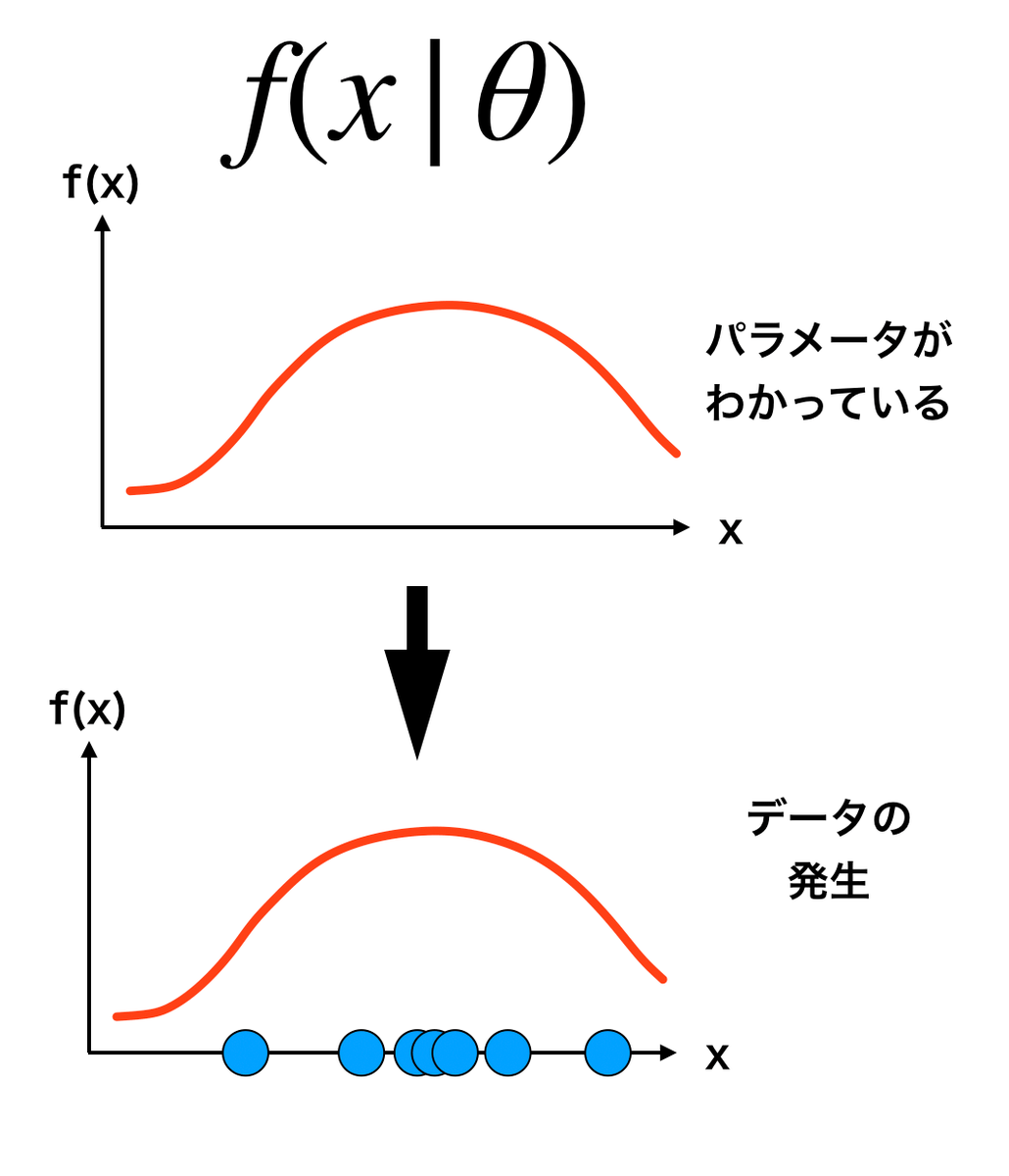

まず尤度関数について定義づける。

パラメータのときに値

である確率は,

と表せる。一方,尤度関数は値が観測されたときのパラメータ

の尤度,

と表される。確率を確率密度関数に拡張して,一般に

かなりたつ(注意:尤度は確率ではない)。

データが複数ある場合,尤度関数は

となる。

よって正規分布の尤度関数は

と表せる。ここで

である(総乗)。

最尤推定とは,尤度関数(以後

を省略)が最大になるパラメータ

を求めることである。最大化するにおいて,対数尤度関数

で計算すると楽である。ここで最尤推定量は

となるである。

よって正規分布では

対数尤度関数:

それぞれ偏微分して0と置くと,

これらの式を連立させて解いたものをそれぞれ,

と置くと,

となる。

応用として,回帰分析における最尤推定が重要である。の誤差

について

- 各

について独立

- 正規分布

に従う

と仮定したときの最尤推定量は,最小二乗法における正規方程式の解と一致する。

クラメール・ラオの不等式に到るまで

最尤推定の延長として,

- スコア関数

- フィッシャー情報量

- クラメール・ラオの不等式

について簡単に説明する。

スコア関数

定義:

つまり,対数尤度関数の微分である。なお,期待値は0である。

フィッシャー情報量

定義:

スコア関数の2次モーメントで定義される。 スコア関数の期待値が0であることから,分散と同義である。

クラメール・ラオの不等式

定義:

簡単にいうと,予想される分散はフィッシャー情報量の逆数以上である。

まとめ

ここまで全12回を4ヶ月に渡って投稿してきた。実際に問題を解くことで,数理統計学にある式の意味がわかるようになったように思う。扱った内容はいずれも基礎的な話であり,今後の応用にどう結びつけるかが重要であろう。

(終)